data(LC19_S1, package = "hecedsm")

modmat <- model.matrix( # Matrice du modèle

~ familiarity + consistency,

data = LC19_S1)

tail(modmat, n = 5L) # Imprimer les premières 5 lignes

#> (Intercept) familiarity consistencyinconsistent

#> 92 1 6 1

#> 93 1 4 1

#> 94 1 7 1

#> 95 1 7 1

#> 96 1 7 1

dim(modmat) # dimension de la matrice du modèle

#> [1] 96 34 Régression linéaire

4.1 Introduction

Le modèle de régression linéaire, ou modèle linéaire, est l’un des outils les plus polyvalents pour l’inférence statistique. La régression linéaire est principalement utilisée pour évaluer les effets des variables explicatives (souvent l’effet d’une manipulation ou d’un traitement dans un cadre expérimental) sur la moyenne d’une variable réponse continue, ou pour la prédiction. Un modèle linéaire est un modèle qui décrit la moyenne d’une variable réponse continue \(Y_i\) d’un échantillon aléatoire de taille \(n\) comme fonction linéaire des variables explicatives (également appelés prédicteurs, régresseurs ou covariables) \(X_1, \ldots, X_p.\)

Dénotons par \(Y_i\) la valeur de \(Y\) pour le sujet \(i,\) et \(X_{ij}\) la valeur de la \(j\)e variable explicative du sujet \(i.\) \[\begin{align} \underset{\text{moyenne conditionnelle}}{\mathsf{E}(Y_i \mid \boldsymbol{X}_i=\boldsymbol{x}_i)}=\mu_i=\underset{\substack{\text{combinaison linéaire (somme pondérée)}\\ \text{de variables explicatives}}}{\beta_0 + \beta_1x_{i1} + \cdots + \beta_p x_{ip}}\equiv \mathbf{x}_i\boldsymbol{\beta}. \end{align}\] où \(\mathbf{x}_i = (1, x_{i1}, \ldots, x_{ip})\) est un vecteur ligne de taille \((p+1)\) contenant les variables explicatives de l’observation \(i\) et \(\boldsymbol{\beta} = (\beta_0, \ldots, \beta_p)^\top\) est un vecteur colonne de longueur \(p+1\) contenant les coefficients de la moyenne. Le fait que la moyenne est conditionnelle aux valeurs de \(\mathbf{X}\) implique simplement que l’on considère les régresseurs comme constant, ou connus à l’avance. Les coefficients \(\boldsymbol{\beta}\) sont les mêmes pour toutes les observations, mais le vecteurs de variables explicatives \(\mathbf{x}_i\) peut différer d’une observation à l’autre. Le modèle est linéaire en \(\beta_0, \ldots, \beta_p,\) pas nécessairement dans les variables explicatives.

Pour simplifier la notation, nous regroupons les observations dans un vecteur \(n\) \(\boldsymbol{Y}\) et les explications dans une matrice \(n \times (p+1)\) \(\mathbf{X}\) en concaténant une colonne de uns et les vecteurs de colonnes \(p\) \(\boldsymbol{X}_1, \ldots, \boldsymbol{X}_p,\) chacun contenant les \(n\) observations des explications respectives. La matrice \(\mathbf{X}\) est appelée matrice du modèle (ou parfois matrice de devis dans un contexte expérimental), et sa \(i\)ème ligne est \(\mathbf{x}_i.\)

En supposant que la variable réponse provient d’une famille de localisation, nous pouvons réécrire le modèle linéaire en termes de la moyenne plus un aléa, \[\begin{align*} \underset{\text{observation}\vphantom{\mu_i}}{Y_i} = \underset{\text{moyenne } \mu_i}{\vphantom{Y_i}\mathbf{x}_i\boldsymbol{\beta}} + \underset{\text{aléa}\vphantom{\mu_i}}{\vphantom{Y_i}\varepsilon_i}, \end{align*}\] où \(\varepsilon_i\) est le terme spécifique à l’observation \(i.\) On assume que les aléas \(\varepsilon_1, \ldots \varepsilon_n\) sont indépendants et identiquement distribués, avec \(\mathsf{E}(\varepsilon_i \mid \mathbf{x}_i) = 0\) et \(\mathsf{Var}(\varepsilon_i \mid \mathbf{x}_i) = \sigma^2.\) On fixe l’espérance de l’aléa à zéro car on postule qu’il n’y a pas d’erreur systématique. La variance \(\sigma^2\) sert à tenir compte du fait qu’aucune relation linéaire exacte ne lie \(\mathbf{x}_i\) et \(Y_i,\) ou que les mesures de \(Y_i\) sont variables.

Le modèle linéaire normal ou gaussien spécifie que les réponses suivent une loi normale, avec \(Y_i \mid \boldsymbol{X}_i=\boldsymbol{x}_i \sim \mathsf{normale}(\mathbf{x}_i\boldsymbol{\beta}, \sigma^2).\) La loi normale est une famille de localisation, de sorte que \(Y \sim \mathsf{normale}(\mu, \sigma^2)\) équivaut à la décomposition additive \(\mu + \varepsilon\) pour \(\varepsilon \sim \mathsf{normale}(0, \sigma^2).\)

4.1.1 Exemples

Considérons quelques exemples de jeux de données qui serviront à illustrer les méthodes par la suite.

Exemple 4.1 (Cohérence de descriptions de produits) L’étude 1 de Lee et Choi (2019) (base de données LC19_S1, paquet hecedsm) considère l’impact sur la perception d’un produit de la divergence entre la description textuelle et l’image. Dans leur première expérience, un paquet de six brosses à dents est vendu, mais l’image montre soit un paquet de six, soit une seule). Les auteurs ont également mesuré la familiarité préalable avec la marque de l’article. Les \(n=96\) participants ont été recrutés à l’aide d’un panel en ligne. Nous pourrions ajuster un modèle linéaire pour le score moyen d’évaluation du produit, prodeval, en fonction de la familiarité de la marque familiarity, un nombre entier allant de 1 à 7, et une variable binaire pour le facteur expérimental consistency, codé 0 pour des descriptions d’image/texte cohérentes et 1 si elles sont incohérentes. La matrice du modèle qui en résulte est alors de dimension \(96\times 3.\) La réponse prodeval est fortement discrétisée.

Exemple 4.2 (Méthodes d’apprentissage de compréhension de lecture) La base de données BSJ92 du paquet hecedsm contient les résultats d’une expérience de Baumann, Seifert-Kessell, et Jones (1992) sur l’efficacité de différentes stratégies de lecture sur la compréhension d’enfants.

Soixante-six élèves de quatrième année ont été assignés au hasard à l’un des trois groupes expérimentaux suivants : (a) un groupe « Think-Aloud » (TA), dans lequel les élèves ont appris diverses stratégies de contrôle de la compréhension pour la lecture d’histoires (par exemple : auto-questionnement, prédiction, relecture) par le biais de la réflexion à haute voix; (b) un groupe lecture dirigée-activité de réflexion (DRTA), dans lequel les élèves ont appris une stratégie de prédiction-vérification pour lire et répondre aux histoires; ou (c) un groupe activité de lecture dirigée (DRA), un groupe contrôle dans lequel les élèves se sont engagés dans une lecture guidée non interactive d’histoires.

Les variables d’intérêt sont group, le facteur pour le groupe expérimental, soit DRTA, TA et DR ainsi que les variables numériques pretest1 et posttest1, qui donnent le score (sur 16) sur le test pré-expérience pour la tâche de détection des erreurs.

Les données sont balancées puisqu’il y a 22 observations dans chacun des trois sous-groupes. Les chercheurs ont appliqué une série de trois évaluations: le test 1 de détection d’erreurs, le test 2 consistant en un questionnaire de suivi de compréhension, et le test 3 standardisé Degrees of Reading Power). Les tests 1 et 2 ont été administrés à la fois avant et après l’intervention: cela nous permet d’établir l’amélioration moyenne de l’élève en ajoutant le résultat du test pré-intervention comme covariable. Les tests 1 étaient sur 16, mais celui administré après l’expérience a été rendu plus difficile pour éviter les cas d’étudiants obtenant des scores presque complets. La corrélation entre le pré-test et le post-test 1 est \((\widehat{\rho}_1=0.57),\) beaucoup plus forte que celle du second test \((\widehat{\rho}_2=0.21).\)

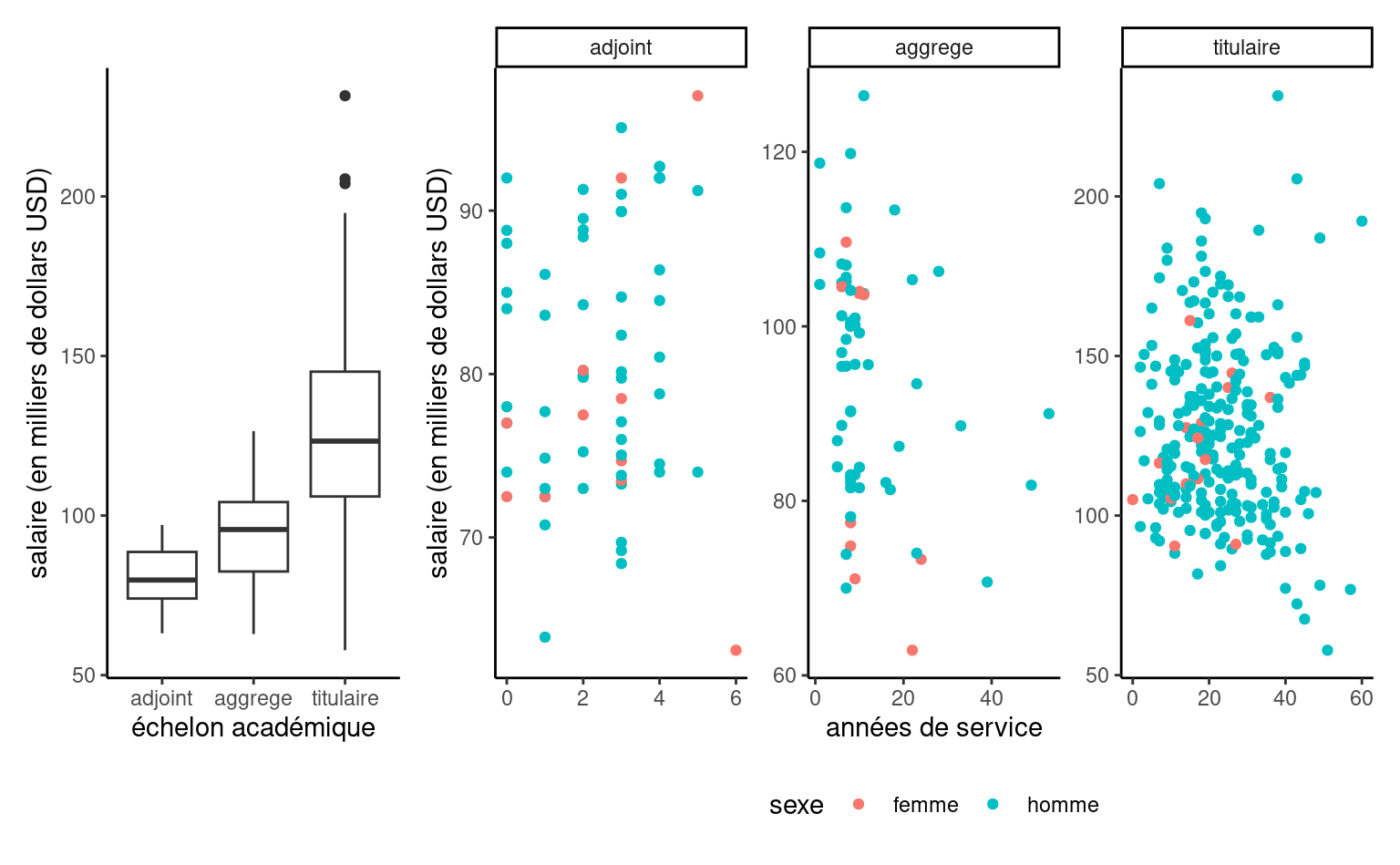

Exemple 4.3 (Discrimination salariale dans un collège américain) On s’intéresse à la discrimination salariale dans un collège américain, au sein duquel une étude a été réalisée pour investiguer s’il existait des inégalités salariales entre hommes et femmes. Le jeu de données college contient les variables suivantes:

salaire: salaire de professeurs pendant l’année académique 2008–2009 (en milliers de dollars USD).echelon: échelon académique, soit adjoint (adjoint), aggrégé (aggrege) ou titulaire (titulaire).domaine: variable catégorielle indiquant le champ d’expertise du professeur, soit appliqué (applique) ou théorique (theorique).sexe: indicateur binaire pour le sexe,hommeoufemme.service: nombre d’années de service.annees: nombre d’années depuis l’obtention du doctorat.

Exemple 4.4 (Suggestion de montants de dons) L’étude 1 de Moon et VanEpps (2023) (données MV23_S1, paquet hecedsm) porte sur la proportion de donateurs à un organisme de charité et le montant de leurs dons. Les participants au panel en ligne avaient la possibilité de gagner 25$ et de faire don d’une partie de cette somme à l’organisme de leur choix. Les données fournies incluent uniquement les personnes qui n’ont pas dépassé ce montant et qui ont indiqué avoir fait un don d’un montant non nul.

Exemple 4.5 (Un emballage en carton supplémentaire est-il considéré comme plus écologique ?) Sokolova, Krishna, et Döring (2023) tient compte des préjugés des consommateurs lorsqu’il s’agit d’évaluer le caractère écologique des emballages. Des produits tels que les céréales sont emballés dans des sacs en plastique, eux-mêmes recouverts d’une boîte. Ils supposent (et constatent) que, paradoxalement, les consommateurs ont tendance à considérer l’emballage comme plus écologique lorsque la quantité de carton ou de carton entourant la boîte est plus importante, ce qui n’est pas le cas. Nous examinons dans la suite les données de l’étude 2A, qui mesure la perception du respect de l’environnement (PEF, variable pef) en fonction de la proportion d’emballage en carton (soit aucun, soit la moitié de la surface du plastique, soit la même, soit le double).

4.1.2 Analyse exploratoire des données

L’analyse exploratoire des données est une procédure itérative par laquelle nous interrogeons les données, en utilisant des informations auxiliaires, des statistiques descriptives et des graphiques, afin de mieux informer notre modélisation.

Elle est utile pour mieux comprendre les caractéristiques des données (plan d’échantillonnage, valeurs manquantes, valeurs aberrantes), la nature des observations, qu’il s’agisse de variables réponse ou explicatives et les interrelations entre variables.

Voir le Chapitre 11 de Alexander (2023) pour des exemples. En particulier, il convient de vérifier

- que les variables catégorielles sont adéquatement traitées comme des facteurs (

factor). - que les valeurs manquantes sont adéquatement déclarées comme telles (code d’erreur, 999, etc.)

- s’il ne vaudrait mieux pas retirer certaines variables explicatives avec beaucoup de valeurs manquantes.

- s’il ne vaudrait mieux pas fusionner des modalités de variables catégorielles si le nombre d’observation par modalité est trop faible.

- qu’il n’y a pas de variable explicative dérivée de la variable réponse

- que le sous-ensemble des observations employé pour l’analyse statistique est adéquat.

- qu’il n’y a pas d’anomalies ou de valeurs aberrantes (par ex., 999 pour valeurs manquantes) qui viendraient fausser les résultats.

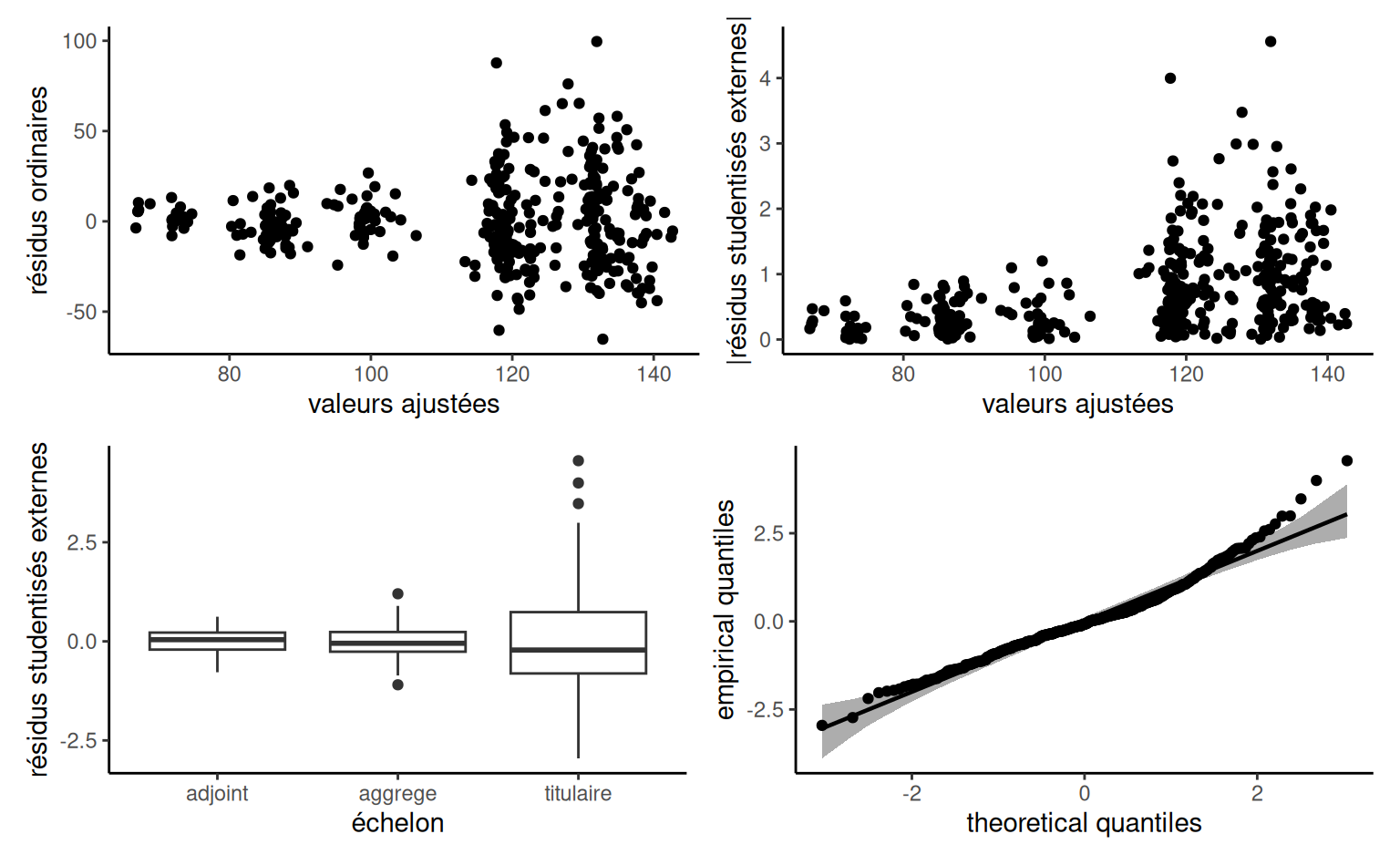

Exemple 4.6 (Analyse exploratoire des données college) Une analyse exploratoire des données est de mise avant d’ébaucher un modèle. Si le salaire augmente au fil des ans, on voit que l’hétérogénéité change en fonction de l’échelon et qu’il y a une relation claire entre ce dernier et le nombre d’années de service (les professeurs n’étant éligibles à des promotions qu’après un certain nombre d’années). Les professeurs adjoints qui ne sont pas promus sont généralement mis à la porte, aussi il y a moins d’occasions pour que les salaires varient sur cette échelle.

college: répartition des salaires en fonction de l’échelon et du nombre d’années de service

Ainsi, le salaire augmente avec les années, mais la variabilité croît également. Les professeurs adjoints qui ne sont pas promus sont généralement mis à la porte, aussi il y a moins d’occasions pour que les salaires varient sur cette échelle. Il y a peu de femmes dans l’échantillon: moins d’information signifie moins de puissance pour détecter de petites différences de salaire. Si on fait un tableau de contingence de l’échelon et du sexe, on peut calculer la proportion relative homme/femme dans chaque échelon: 16% des profs adjoints, 16% pour les aggrégés, mais seulement 7% des titulaires alors que ces derniers sont mieux payés en moyenne.

| adjoint | aggrege | titulaire | |

|---|---|---|---|

| femme | 11 | 10 | 18 |

| homme | 56 | 54 | 248 |

Plusieurs des variables explicatives potentielles des données college sont cat/gorielles (echelon, sexe, discipline), les deux dernières étant binaires. Les variables numériques annees et service sont fortement corrélées, avec une corrélation linéaire de 0.91.

Exemple 4.7 (Analyse exploratoire et données manquantes) Il convient de vérifier pour les données de Moon et VanEpps (2023) que la description de la collecte coïncide avec la structure. Puisque les personnes qui n’ont pas donné ne remplissent pas le champ pour le montant, ce dernier indique une valeur manquante. Tous les montants des dons sont entre 0.25$ et 25.$

data(MV23_S1, package = "hecedsm")

str(MV23_S1)

#> tibble [869 × 4] (S3: tbl_df/tbl/data.frame)

#> $ before : int [1:869] 0 1 0 1 1 1 1 0 1 0 ...

#> $ donate : int [1:869] 0 0 0 1 1 0 1 0 0 1 ...

#> $ condition: Factor w/ 2 levels "open-ended","quantity": 1 1 1 1 2 2 2 1 1 1 ...

#> $ amount : num [1:869] NA NA NA 10 5 NA 20 NA NA 25 ...

summary(MV23_S1)

#> before donate condition amount

#> Min. :0.000 Min. :0.00 open-ended:407 Min. : 0.25

#> 1st Qu.:0.000 1st Qu.:0.00 quantity :462 1st Qu.: 5.00

#> Median :1.000 Median :1.00 Median :10.00

#> Mean :0.596 Mean :0.73 Mean :10.69

#> 3rd Qu.:1.000 3rd Qu.:1.00 3rd Qu.:15.00

#> Max. :1.000 Max. :1.00 Max. :25.00

#> NA's :1 NA's :235Si nous incluons amount comme variable réponse dans un modèle de régression, les 235 observations manquantes seront supprimées par défaut. Cela ne pose pas de problème si nous voulons comparer le montant moyen des personnes qui ont fait un don, mais dans le cas contraire, nous devons transformer les NA en zéros. La variable donate ne doit pas être incluse comme variable explicative dans le modèle, car elle permet de prédire exactement les personnes qui n’ont pas donné.

4.1.3 Spécification du modèle pour la moyenne

La première étape d’une analyse consiste à décider quelles variables explicatives doivent être ajoutées à l’équation de la moyenne, et sous quelle forme. Les modèles ne sont que des approximations de la réalité; la section 2.1 de Venables (2000) affirme que, si nous pensons que la véritable fonction moyenne reliant les variables explicatives \(\boldsymbol{X}\) et la réponse \(Y\) est de la forme \(\mathsf{E}(Y \mid \boldsymbol{X}) = f(\boldsymbol{X})\) pour \(f\) suffisamment lisse, alors le modèle linéaire est une approximation du premier ordre. À des fins d’interprétation, il est logique de centrer sur la moyenne toute variable explicative continue, car cela facilite l’interprétation.

Dans un cadre expérimental, où la condition expérimentale est attribué de manière aléatoire, nous pouvons directement comparer les différents traitements et tirer des conclusions causales (puisque toutes les autres choses sont égales en moyenne constantes, toute différence détectable est due en moyenne à notre manipulation). Bien que nous nous abstenions généralement d’inclure d’autres variables explicatives afin de préserver la simplicité du modèle, il peut néanmoins être utile de prendre en compte certaines variables concomitantes qui expliquent une partie de la variabilité afin de filtrer le bruit de fond et d’augmenter la puissance de l’étude. Par exemple, pour les données de Baumann, Seifert-Kessell, et Jones (1992), l’objectif est de comparer les scores moyens en fonction de la méthode d’enseignement, nous inclurions group. Dans cet exemple, il serait également logique d’inclure le résultat pretest1 en tant qu’élément explicatif pour posttest1. De cette façon, nous modéliserons la différence moyenne d’amélioration entre le pré-test et le post-test plutôt que le résultat final.

Dans un contexte observationnel, les participants dans différents groupes ont des caractéristiques différentes et nous devons donc tenir compte de ces différences. Les modèles linéaires utilisés en économie et en finance contiennent souvent des variables de contrôle au modèle pour tenir compte des différences potentielles dues aux variables sociodémographiques (âge, revenu, etc.) qui seraient corrélées à l’appartenance aux groupes. Tout test de coefficients ne prendrait en compte que la corrélation entre le résultat \(Y\) et le facteur explicatif postulé d’intérêt.

4.2 Interprétation des coefficients

La spécification de la moyenne est \[\begin{align*} \mathsf{E}(Y_i \mid \boldsymbol{X}_i = \boldsymbol{x}_i) = \beta_0 + \beta_1 x_{i1} + \cdots + \beta_p x_{ip}. \end{align*}\] L’ordonnée à l’origine \(\beta_0\) est la valeur moyenne de \(Y\) lorsque toutes les variables explicatives du modèles sont nulles, soit \(\boldsymbol{x}_i=\boldsymbol{0}_p.\) \[\begin{align*} \beta_0 &= \mathsf{E}(Y \mid X_1=0,X_2=0,\ldots,X_p=0) \\ &= \beta_0 + \beta_1 \times 0 + \beta_2 \times 0 + \cdots + \beta_p \times 0 \end{align*}\] Bien sur, il se peut que cette interprétation n’ait aucun sens dans le contexte étudié. Centrer les variables explicatives numériques (pour que leurs moyennes soit zéro) permet de rendre l’ordonnée à l’origine plus interprétable.

En régression linéaire, le paramètre \(\beta_j\) mesure l’effet de la variable \(X_j\) sur la variable \(Y\) une fois que l’on tient compte des effets des autres variables explicatives. Pour chaque augmentation d’une unité de \(X_j,\) la réponse \(Y\) augmente en moyenne de \(\beta_j\) lorsque les autres variables demeurent inchangées, \[\begin{align*} \beta_j &= \mathsf{E}(Y \mid X_j= x_j+1, \boldsymbol{X}_{-j} = \boldsymbol{x}_{-j}) - \mathsf{E}(Y \mid \boldsymbol{X} = \boldsymbol{x}) \\ &= \sum_{\substack{k=1\\k \neq j}}^p \beta_kx_k + \beta_j(x_j+1) - \sum_{k=1}^p \beta_k x_k \end{align*}\]

Définition 4.1 (Effet marginal) On définit l’effet marginal comme la dérivée première de la moyenne conditionnelle par rapport à \(X_j,\) soit \[\text{effet marginal de }X_j = \frac{\partial \mathsf{E}(Y \mid \boldsymbol{X})}{ \partial X_j}.\] Le coefficient \(\beta_j\) est aussi l’effet marginal de la variable \(X_j.\)

Les variables indicatrices, qui prennent typiquement des valeurs de \(-1,\) \(0\) et \(1,\) servent à indiquer l’appartenance aux différentes modalités d’une variable catégorielle. Par exemple, pour une variable indicatrice binaire, nous pouvons créer une colonne dont les entrées sont \(1\) pour le groupe de traitement et \(0\) pour le groupe de contrôle.

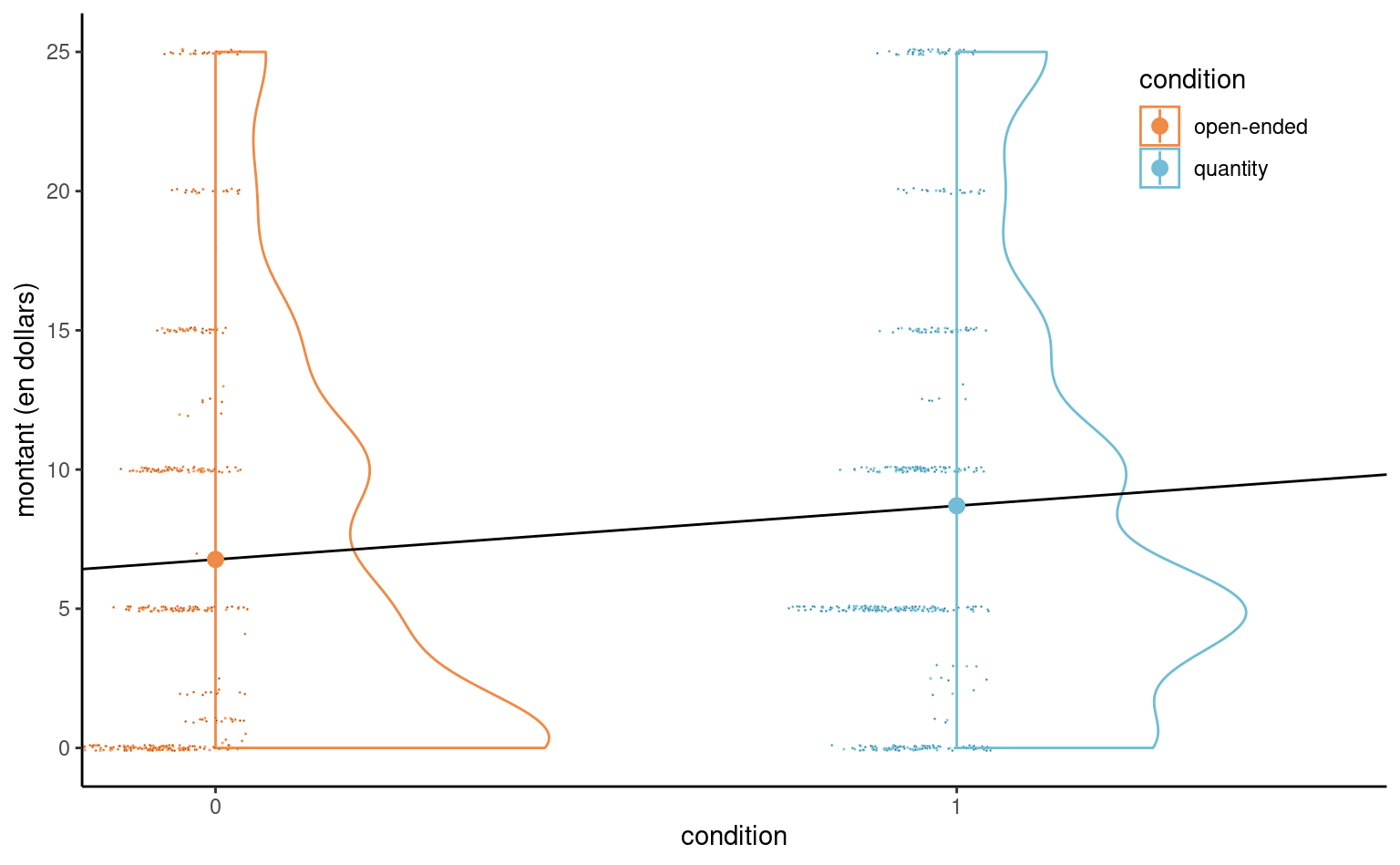

Exemple 4.8 (Modèle linéaire avec une seule variable binaire) Considérons par exemple un modèle linéaire pour les données de Moon et VanEpps (2023) qui inclut le montant (amount) (en dollars, de 0 pour les personnes qui n’ont pas fait de don, jusqu’à 25 dollars).

L’équation du modèle linéaire simple qui inclut la variable binaire condition est \[\begin{align*}

\mathsf{E}(\texttt{amount} \mid \texttt{condition})&= \beta_0 + \beta_1 \mathbf{1}_{\texttt{condition}=\texttt{quantity}}.

\\&= \begin{cases}

\beta_0, & \texttt{condition}=0, \\

\beta_0 + \beta_1 & \texttt{condition}=1.

\end{cases}

\end{align*}\] Soit \(\mu_0\) l’espérance du montant pour le groupe contrôle (open-ended) et \(\mu_1\) celui des participants du groupe de traitement (quantity). Un modèle linéaire qui ne contient qu’une variable binaire \(X\) comme régresseur revient à spécifier une moyenne différente pour chacun des deux groupes. L’ordonnée à l’origine \(\beta_0\) est la moyenne du groupe contrôle. La moyenne du groupe traitement (quantity) est \(\beta_0 + \beta_1 = \mu_1\) et donc \(\beta_1=\mu_1-\mu_0\) est la différence du montant moyen de dons entre le groupe open-ended et le groupe quantity. Cette paramétrisation est commode si on veut tester s’il y a une différence moyenne entre les deux groupes, puisque cette hypothèse nulle correspond à \(\mathscr{H}_0: \beta_1=0.\)

MV23_S1 avec condition comme variable explicative binaire, avec nuage de points décalés et un diagramme en demi-violin. Les cercles indiquent les moyennes de l’échantillon.

Même si le modèle linéaire définit une droite, cette dernière ne peut être évaluée qu’à \(0\) ou \(1;\) la Figure 4.2 montre cette droite avec en plus un nuage de points des montants, décalés horizontalement, et de la densité pour chaque condition. Le point coloré indique la moyenne empirique, qui correspond aux estimations.

Même s’il est clair que les données sont fortement discrétisées avec beaucoup de doublons et de zéros, l’échantillon a une taille de 869 observations, donc les conclusions quant aux moyennes de groupe seront fiables.

Considérons des variables catégorielles avec \(K > 2\) niveaux, qui dans R sont de la classe factor. La paramétrisation par défaut des facteurs se fait en termes de contraste de traitement: le niveau de référence du facteur (par défaut, la première valeur dans l’ordre alphanumérique) sera traité comme la catégorie de référence et assimilé à l’ordonnée à l’origine. Le logiciel créera alors un ensemble de \(K-1\) variables indicatrices pour un facteur à \(K\) niveaux, chacune d’entre elles ayant un pour la catégorie représentée et zéro dans le cas contraire.

Exemple 4.9 (Codage binaire pour les variables catégorielles) Considérons l’étude de Baumann, Seifert-Kessell, et Jones (1992) et la seule variable group. Les données sont classées par groupe : les 22 premières observations concernent le groupe DR, les 22 suivantes le groupe DRTA et les 22 dernières le groupe TA. Si nous ajustons un modèle avec groupe comme variable catégorielle

data(BSJ92, package = "hecedsm")

class(BSJ92$group) # Vérifier que group est un facteur

#> [1] "factor"

levels(BSJ92$group) # première valeur est la catégorie de référence

#> [1] "DR" "DRTA" "TA"

# Imprimer trois lignes de la matrice du modèle

# (trois enfants de groupes différents)

model.matrix(~ group, data = BSJ92)[c(1,23,47),]

#> (Intercept) groupDRTA groupTA

#> 1 1 0 0

#> 23 1 1 0

#> 47 1 0 1

# Comparer avec les niveaux des facteurs

BSJ92$group[c(1,23,47)]

#> [1] DR DRTA TA

#> Levels: DR DRTA TASi nous ajustons un modèle avec groupe comme variable catégorielle, la spécification de la moyenne du modèle est \[\mathsf{E}(Y \mid \texttt{group})= \beta_0 + \beta_1\mathbf{1}_{\texttt{group}=\texttt{DRTA}} + \beta_2\mathbf{1}_{\texttt{group}=\texttt{TA}}.\] Puisque la variable group est catégorielle avec \(K=3\) niveaux, il nous faut mettre \(K-1 = 2\) variables indicatrices.

Avec la paramétrisation en termes de traitements (option par défaut), on obtient

- \(\mathbf{1}_{\texttt{group}=\texttt{DRTA}}=1\) si

group=DRTAet zéro sinon, - \(\mathbf{1}_{\texttt{group}=\texttt{TA}}=1\) si

group=TAet zéro sinon.

Étant donné que le modèle comprend une ordonnée à l’origine et que le modèle décrit en fin de compte trois moyennes de groupe, nous n’avons besoin que de deux variables supplémentaires. Avec la paramétrisation en termes de traitements, la moyenne du groupe de référence est l’ordonnée à l’origine. Si group=DR (référence), les deux variables indicatrices binaires groupDRTA et groupTA sont nulles. La moyenne de chaque groupe est

- \(\mu_{\texttt{DR}} = \beta_0,\)

- \(\mu_{\texttt{DRTA}}=\beta_0 + \beta_1\) et

- \(\mu_{\texttt{TA}} = \beta_0 + \beta_2.\)

Ainsi, \(\beta_1\) est la différence de moyenne entre les groupes DRTA etDR, et de la même façon \(\beta_2=\mu_{\texttt{TA}}- \mu_{\texttt{DR}}.\)

Remarque 4.1 (Contrainte de somme nulle). La paramétrisation discutée ci-dessus, qui est la valeur par défaut de la fonction lm, n’est pas la seule disponible. Plutôt que de comparer la moyenne de chaque groupe avec celle d’une catégorie de référence, la paramétrisation par défaut pour les modèles d’analyse de la variance est en termes de contraintes de somme nulle pour les coefficients, où l’ordonnée à l’origine est la moyenne équi-pondérée de chaque groupe, et les paramètres \(\beta_1, \ldots, \beta_{K-1}\) sont des différences par rapport à cette moyenne.

model.matrix(

~ group,

data = BSJ92,

contrasts.arg = list(group = "contr.sum"))| (Intercept) | group1 | group2 | |

|---|---|---|---|

| DR | 1 | 1 | 0 |

| DRTA | 1 | 0 | 1 |

| TA | 1 | -1 | -1 |

Dans la contrainte de somme nulle, nous obtenons à nouveau deux variables indicatrices, group1 et group2, ainsi que l’ordonnée à l’origine. La valeur de group1 est \(1\) si group=DR, \(0\) si group=DRTA et \(-1\) si group=TA. ous trouvons \(\mu_{\texttt{DR}} = \beta_0 + \beta_1,\) \(\mu_{\texttt{DRTA}}=\beta_0 + \beta_2\) et \(\mu_{\texttt{TA}} = \beta_0 - \beta_1 - \beta_2.\) Quelques manipulations algébriques révèlent que \(\beta_0 = (\mu_{\texttt{DR}} +\mu_{\texttt{DRTA}}+\mu_{\texttt{TA}})/3,\) l’espérance équipondérée des différents niveaux. De manière générale, l’ordonnée à l’origine moins la somme de tous les autres coefficients liés aux facteurs.

En supprimant l’ordonnée à l’origine, on pourrait inclure trois variables indicatrices pour chaque niveau d’un facteur et chaque paramètre correspondrait alors à la moyenne. Ce n’est pas recommandé dans R car le logiciel traite différemment les modèles sans ordonnée à l’origine et certains résultats seront absurdes (par exemple, le coefficient de détermination sera erroné).

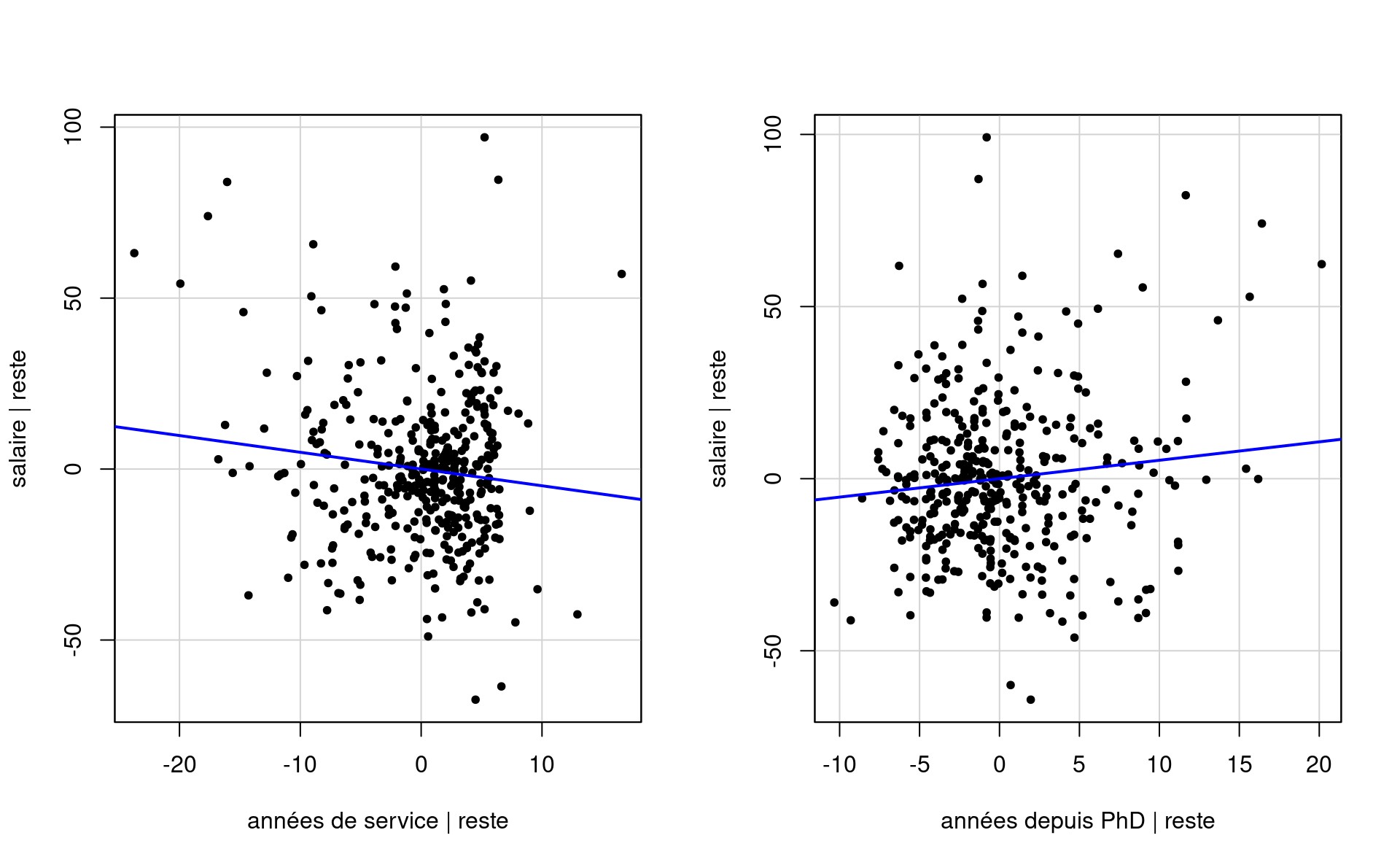

Exemple 4.10 (Interprétation des coefficients) On considère un modèle de régression pour les données college qui inclut le sexe, l’échelon académique, le nombre d’années de service et le domaine d’expertise (appliquée ou théorique).

Le modèle linéaire postulé s’écrit

\[\begin{align*} \texttt{salaire} &= \beta_0 + \beta_1 \mathbf{1}_{\texttt{sexe}=\texttt{femme}} +\beta_2 \mathbf{1}_{\texttt{domaine}=\texttt{theorique}} \\&\quad +\beta_3 \mathbf{1}_{\texttt{echelon}=\texttt{aggrege}} +\beta_4 \mathbf{1}_{\texttt{echelon}=\texttt{titulaire}} \\&\quad+\beta_5 \texttt{service} + \varepsilon. \end{align*}\]

| \(\widehat{\beta}_0\) | \(\widehat{\beta}_1\) | \(\widehat{\beta}_2\) | \(\widehat{\beta}_3\) | \(\widehat{\beta}_4\) | \(\widehat{\beta}_5\) |

|---|---|---|---|---|---|

| 86596 | -4771 | -13473 | 14560 | 49160 | -89 |

L’interprétation des coefficients est la suivante:

- L’ordonnée à l’origine \(\beta_0\) correspond au salaire moyen d’un professeur adjoint (un homme) qui vient de compléter ses études et qui travaille dans un domaine appliqué: on estime ce salaire à \(\widehat{\beta}_0=86596\) dollars.

- toutes choses étant égales par ailleurs (même domaine, échelon et années depuis le dernier diplôme), l’écart de salaire entre un homme et un femme est estimé à \(\widehat{\beta}_1=-4771\) dollars.

- ceteris paribus, un(e) professeur(e) qui oeuvre dans un domaine théorique gagne \(\beta_2\) dollars de plus qu’une personne du même sexe dans un domaine appliqué; on estime cette différence à \(-13473\) dollars.

- ceteris paribus, la différence moyenne de salaire entre professeurs adjoints et aggrégés est estimée à \(\widehat{\beta}_3=14560\) dollars.

- ceteris paribus, la différence moyenne de salaire entre professeurs adjoints et titulaires est de \(\widehat{\beta}_4=49160\) dollars.

- au sein d’un même échelon, chaque année supplémentaire de service mène à une augmentation de salaire annuelle moyenne de \(\widehat{\beta}_5=-89\) dollars.

Remarque 4.2 (Polynômes). Il n’est pas toujours possible de fixer la valeur des autres colonnes de \(\mathbf{X}\) si plusieurs colonnes contiennent des transformations ou des fonctions d’une même variable explicative. Par exemple, on pourrait par exemple considérer un polynôme d’ordre \(k\) (ordinairement, on va prendre \(k\leq 3\)), \[\begin{align*} \mathsf{E}(Y \mid X=x)=\beta_0+ \beta_1 x+ \beta_2 x^2 + \cdots +\beta_k x^k. \end{align*}\] Si l’on inclut un terme d’ordre \(k,\) \(x^k,\) il faut toujours inclure les termes d’ordre inférieur \(1, x, \ldots, x^{k-1}\) pour l’interprétabilité du modèle résultant (autrement, cela revient à choisir un polynôme en imposant que certains coefficients soient zéros). L’interprétation des effets des covariables nonlinéaires (même polynomiaux) est complexe parce qu’on ne peut pas « fixer la valeur des autres variables »: l’effet d’une augmentation d’une unité de \(x\) dépend de la valeur de cette dernière. L’effet marginal de \(x\) est \(\beta_1 + \sum_{j=1}^{k-1}j \beta_{j+1}x^j.\)

L’utilisation de polynôme, plus flexibles, n’est généralement pas recommendée car ces derniers se généralisent mal hors de l’étendue observée des données. L’utilisation de splines avec une pénalité sur les coefficients, avec des modèles additifs, offre plus de flexibilité.

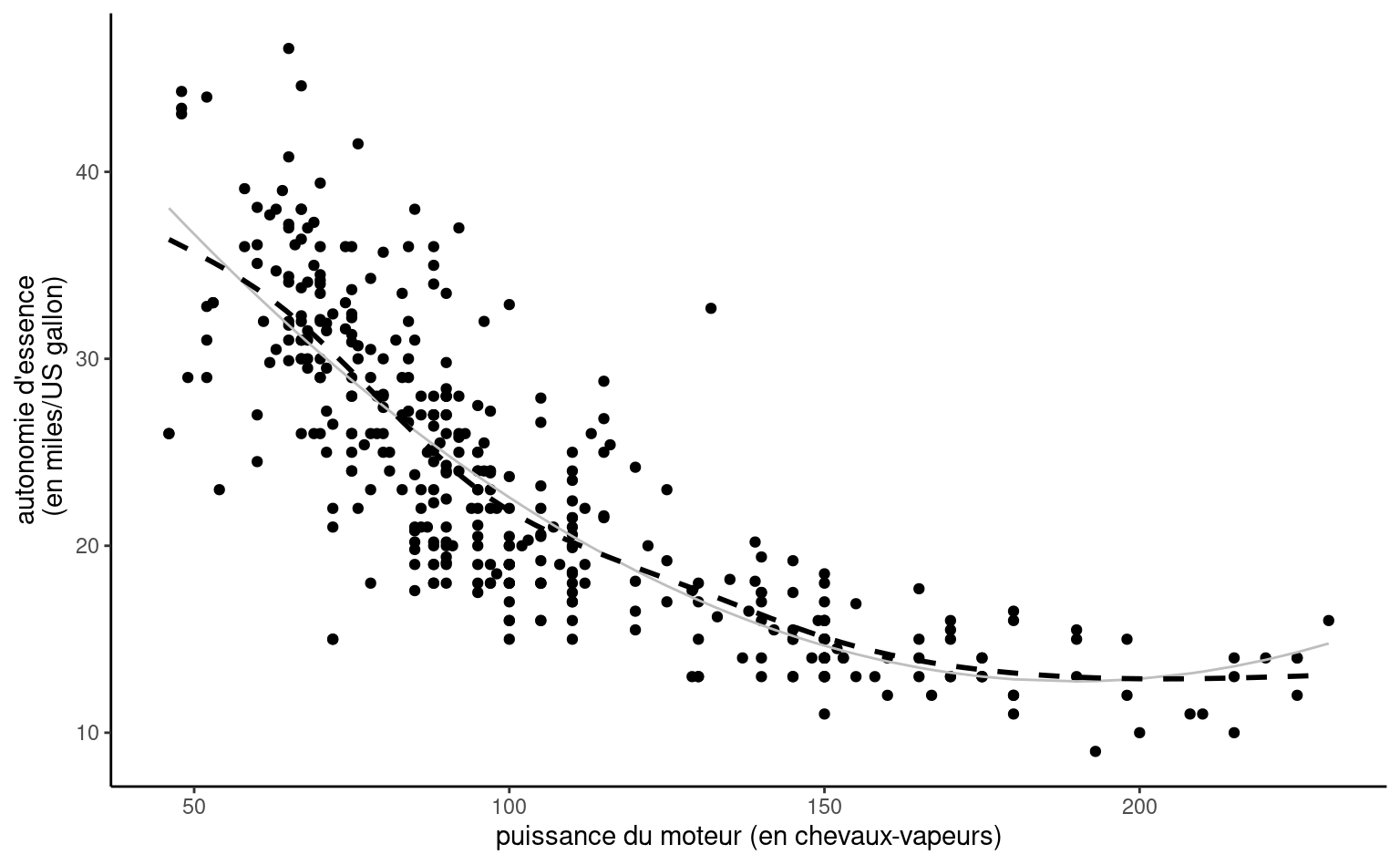

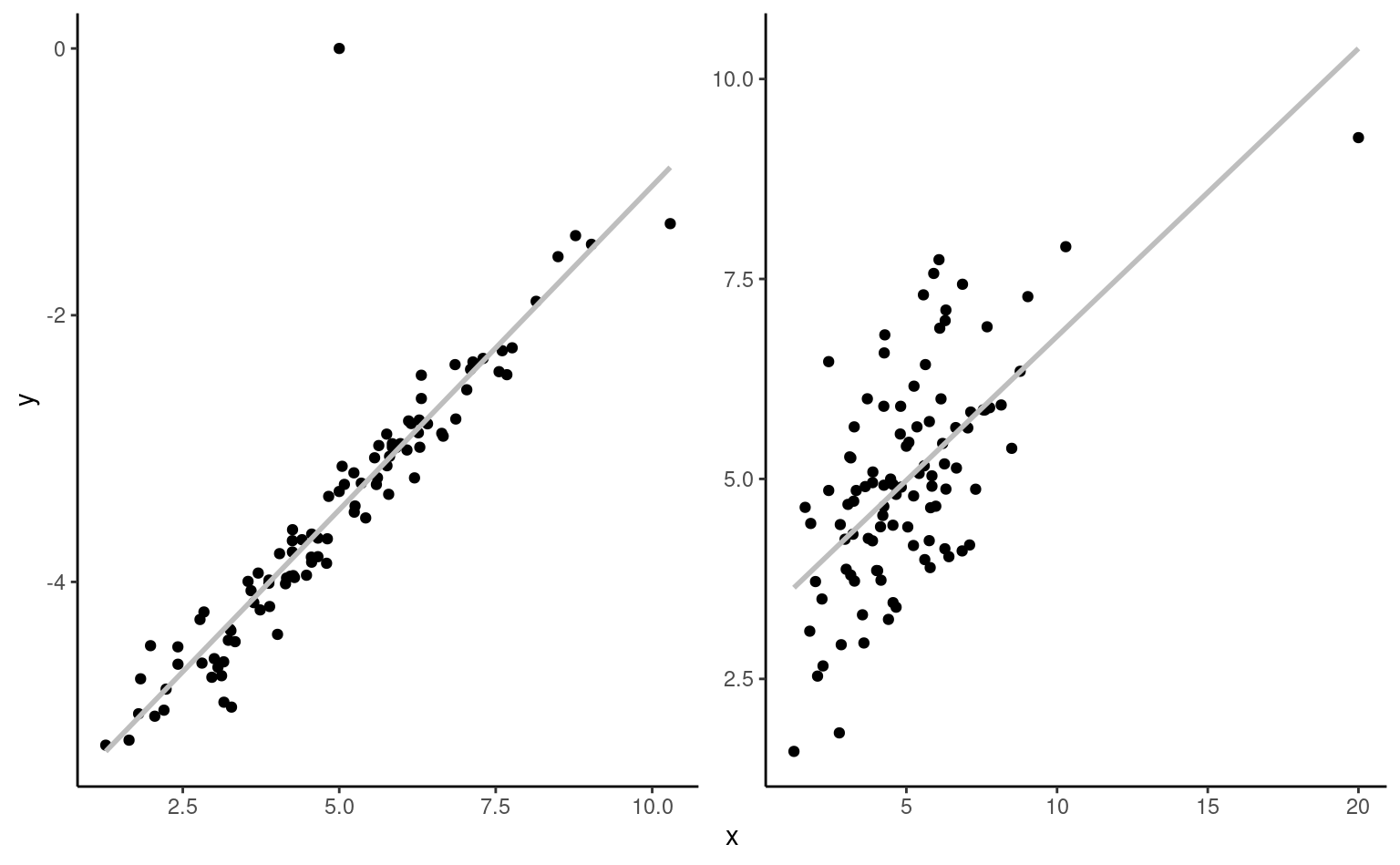

Exemple 4.11 (Modèle quadratique pour les données automobile) Considérons un modèle de régression linéaire pour l’autonomie d’essence en fonction de la puissance du moteur pour différentes voitures dont les caractéristiques sont données dans le jeu de données automobiles. Le modèle postulé incluant un terme quadratique est \[\begin{align*}

\texttt{autonomie}_i = \beta_0 + \beta_1 \texttt{puissance}_i + \beta_2 \texttt{puissance}_i^2 + \varepsilon_i

\end{align*}\] Afin de comparer l’ajustement du modèle quadratique, on peut inclure également la droite ajustée du modèle de régression simple qui n’inclut que puissance.

À vue d’oeil, l’ajustement quadratique est bon: nous verrons plus tard à l’aide de test si une simple droite aurait été suffisante. On voit aussi dans la Figure 4.3 que l’autonomie d’essence décroît rapidement quand la puissance croît entre \(0\) et \(189.35,\) mais semble remonter légèrement par la suite pour les voitures qui un moteur de plus de 200 chevaux-vapeurs, ce que le modèle quadratique capture. Prenez garde en revanche à l’extrapolation là où vous n’avez pas de données (comme l’illustre remarquablement bien le modèle cubique de Hassett pour le nombre de cas quotidiens de coronavirus).

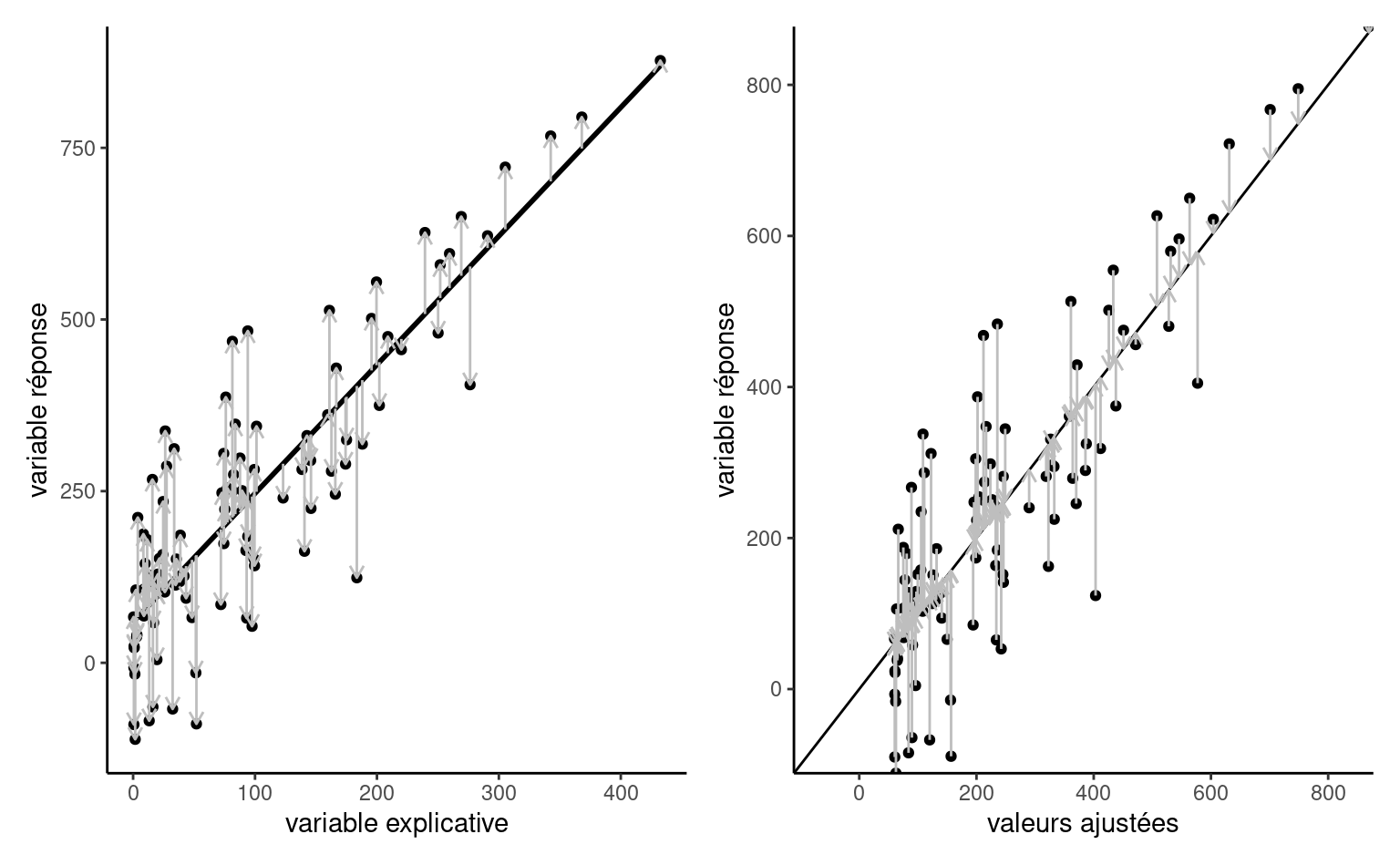

La représentation graphique du modèle polynomial de degré 2 présenté dans la Figure 4.3 peut sembler contre-intuitive, mais c’est une projection en 2D d’un plan 3D de coordonnées \(\beta_0 + \beta_1x-y +\beta_2z =0,\) où \(x=\texttt{puissance},\) \(z=\texttt{puissance}^2\) et \(y=\texttt{autonomie}.\) La physique et le bon-sens imposent la contrainte \(z = x^2,\) et donc les valeurs ajustées vivent sur une courbe dans un sous-espace du plan ajusté, représenté en gris dans la Figure 4.4.

4.3 Estimation des paramètres

Considérons un échantillon de \(n\) observations. On n’observe ni les aléas \(\boldsymbol{\varepsilon},\) ni les paramètres \(\boldsymbol{\beta}\): il est donc impossible de recouvrer les (vrais) coefficients du modèle. Effectivement, le système d’équation spécifié par le modèle linéaire inclut \(n+p+1\) inconnues, mais uniquement \(n\) observations. Si on se concentre sur les \(p+1\) paramètres de moyenne et sur la variance \(\sigma^2,\) nous pourrons estimer les paramètres généralement si \(n> p+2,\) mais cela dépend de la spécification. Une infinité de plans pourraient passer dans le nuage de points; il faut donc choisir la meilleure droite (selon un critère donné). La section aborde le choix de ce critère et l’estimation des paramètres de la moyenne.

4.3.1 Moindres carrés ordinaires

Soit une matrice de modèle \(\mathbf{X}\) et une formulation pour la moyenne avec \(\mathsf{E}(Y_i) = \mathbf{x}_i\boldsymbol{\beta}.\) Les estimateurs des moindres carrés ordinaires \(\widehat{\boldsymbol{\beta}}=(\widehat{\beta}_0, \ldots, \widehat{\beta}_p)\) sont les paramètres qui minimisent simultanément la distance euclidienne entre les observations \(y_i\) et les valeurs ajustées \(\widehat{y}_i=\mathbf{x}_i\widehat{\boldsymbol{\beta}}.\)

En d’autres mots, les estimateurs des moindres carrés sont la solution du problème d’optimization convexe \[\begin{align*} \widehat{\boldsymbol{\beta}} &=\min_{\boldsymbol{\beta} \in \mathbb{R}^{p+1}}\sum_{i=1}^n (Y_i-\widehat{Y}_i)^2= \min_{\boldsymbol{\beta}} \|\boldsymbol{Y}-\mathbf{X}\boldsymbol{\beta}\|^2 \end{align*}\] Ce système d’équation a une solution explicite qui est plus facilement exprimée en notation matricielle. Soit les matrices et vecteurs \[\begin{align*} \boldsymbol{Y} = \begin{pmatrix} Y_1 \\ Y_2 \\ \vdots \\ Y_n \end{pmatrix} , \; \mathbf{X} = \begin{pmatrix} 1 & x_{11} & x_{12} & \cdots & x_{1p} \\ 1 & x_{21} & x_{22} & \cdots & x_{2p} \\ \vdots & \vdots & \ddots & \vdots \\ 1 & x_{n1} & x_{n2} & \cdots & x_{np} \end{pmatrix} , \; \boldsymbol{\beta} = \begin{pmatrix} \beta_1 \\ \beta_2 \\ \vdots \\ \beta_p \end{pmatrix} \end{align*}\]

Proposition 4.1 (Moindres carrés ordinaires) L’estimateur des moindres carrés ordinaires résoud le problème d’optimisation non-contraint \[\begin{align*} \widehat{\boldsymbol{\beta}}=\min_{\boldsymbol{\beta} \in \mathbb{R}^{p+1}}(\boldsymbol{y}-\mathbf{X}\boldsymbol{\beta})^\top(\boldsymbol{y}-\mathbf{X}\boldsymbol{\beta}). \end{align*}\] On peut calculer la dérivée première par rapport à \(\boldsymbol{\beta},\) égaler à zéro et isoler le maximum pour obtenir une formule explicite pour \(\widehat{\boldsymbol{\beta}},\) \[\begin{align*} \mathbf{0}_n&=\frac{\partial}{\partial\boldsymbol{\beta}}(\boldsymbol{y}-\mathbf{X}\boldsymbol{\beta})^\top(\boldsymbol{y}-\mathbf{X}\boldsymbol{\beta})\\ \\&=\frac{\partial (\boldsymbol{y}-\mathbf{X}\boldsymbol{\beta})}{\partial \boldsymbol{\beta}}\frac{\partial (\boldsymbol{y}-\mathbf{X}\boldsymbol{\beta})^\top(\boldsymbol{y}-\mathbf{X}\boldsymbol{\beta})}{\partial (\boldsymbol{y}-\mathbf{X}\boldsymbol{\beta})}\\ \\&=\mathbf{X}^\top (\boldsymbol{y}-\mathbf{X}\boldsymbol{\beta}) \end{align*}\] en utilisant la règle de dérivation en chaîne; on peut ainsi distribuer les termes pour obtenir l’équation normale \[\begin{align*} \mathbf{X}^\top \mathbf{X}\boldsymbol{\beta}&=\mathbf{X}^\top \boldsymbol{y}. \end{align*}\] Si \(\mathbf{X}\) est une matrice de rang \(p,\) alors la forme quadratique \(\mathbf{X}^\top \mathbf{X}\) est inversible et l’unique solution du problème d’optimisation est \[\begin{align*} \widehat{\boldsymbol{\beta}} = (\mathbf{X}^{\top} \mathbf{X})^{-1} \mathbf{X}^{\top} \boldsymbol{Y}. \end{align*}\] Si le rang de la matrice \(\mathbf{X}\) est dimension \(n \times (p+1)\) est de rang \(p+1,\) l’unique solution du problème d’optimisation est \[ \widehat{\boldsymbol{\beta}} = (\mathbf{X}^{\top} \mathbf{X})^{-1} \mathbf{X}^{\top} \boldsymbol{Y}. \tag{4.1}\] Cet estimateur dit des moindres carrés ordinaires (MCO) est explicite; il n’est donc pas nécessaire de procéder à l’optimisation à l’aide d’algorithmes numériques.

4.3.2 Maximum de vraisemblance

Nous pourrions également envisager l’estimation du maximum de vraisemblance. Proposition 4.2 montre que, en supposant la normalité des aléas, les estimateurs des moindres carrés de \(\boldsymbol{\beta}\) coïncident avec ceux du maximum de vraisemblance.

Proposition 4.2 (Estimation du maximum de vraisemblance du modèle linéaire normal) Le modèle de régression linéaire spécifie que les observations \(Y_i \sim \mathsf{normale}(\mathbf{x}_i\boldsymbol{\beta}, \sigma^2)\) sont indépendantes. Le modèle linéaire a \(p+2\) paramètres (\(\boldsymbol{\beta}\) et \(\sigma^2\)) et la log-vraisemblance est, abstraction faite des termes constants, \[\begin{align*} \ell(\boldsymbol{\beta}, \sigma)&\propto-\frac{n}{2} \ln (\sigma^2) -\frac{1}{2\sigma^2}(\boldsymbol{y}-\mathbf{X}\boldsymbol{\beta})^\top(\boldsymbol{y}-\mathbf{X}\boldsymbol{\beta}). \end{align*}\] Maximiser la log-vraisemblance par rapport à \(\boldsymbol{\beta}\) revient à minimiser la somme du carré des erreurs \(\sum_{i=1}^n (y_i - \mathbf{x}_i\boldsymbol{\beta})^2,\) quelle que soit la valeur de \(\sigma,\) et on recouvre \(\widehat{\boldsymbol{\beta}}.\) L’estimateur du maximum de vraisemblance de la variance \(\widehat{\sigma}^2\) est \[\begin{align*} \widehat{\sigma}^2=\mathrm{arg max}_{\sigma^2} \ell(\widehat{\boldsymbol{\beta}}, \sigma^2). \end{align*}\] La log-vraisemblance profilée de \(\sigma^2,\) abstraction faite des constantes, est \[\begin{align*} \ell_{\mathrm{p}}(\sigma^2) &\propto-\frac{1}{2}\left\{n\ln\sigma^2+\frac{1}{\sigma^2}(\boldsymbol{y}-\mathbf{X}\hat{\boldsymbol{\beta}})^\top(\boldsymbol{y}-\mathbf{X}\hat{\boldsymbol{\beta}})\right\}. \end{align*}\] En différenciant chaque terme par rapport à \(\sigma^2\) et en fixant le gradient à zéro, on obtient \[\begin{align*} \frac{\partial \ell_{\mathrm{p}}(\sigma^2)}{\partial \sigma^2} = -\frac{n}{2\sigma^2} + \frac{(\boldsymbol{y}-\mathbf{X}\hat{\boldsymbol{\beta}})^\top(\boldsymbol{y}-\mathbf{X}\hat{\boldsymbol{\beta}})}{2\sigma^4} = 0 \end{align*}\]

On déduit que l’estimateur du maximum de vraisemblance est la moyenne des carrés des résidus, \[\begin{align*} \widehat{\sigma}^2&=\frac{1}{n}(\boldsymbol{Y}-\mathbf{X}\hat{\boldsymbol{\beta}})^\top(\boldsymbol{Y}-\mathbf{X}\hat{\boldsymbol{\beta}})\\&= \frac{1}{n} \sum_{i=1}^n (y_i - \mathbf{x}_i\widehat{\boldsymbol{\beta}})^2= \frac{\mathsf{SC}_e}{n}; \end{align*}\] L’estimateur sans biais habituel de \(\sigma^2\) calculé par le logiciel est \[S^2=\mathsf{SC}_e/(n-p-1), \] où le dénominateur est la taille de l’échantillon \(n\) moins le nombre de paramètres de la moyenne \(\boldsymbol{\beta},\) soit \(p+1.\)

Proposition 4.3 (Matrices d’information pour modèles linéaires normaux.) Les entrées de la matrice d’information observée du modèle linéaire normal sont les suivantes \[\begin{align*} -\frac{\partial^2 \ell(\boldsymbol{\beta}, \sigma^2)}{\partial \boldsymbol{\beta}\partial \boldsymbol{\beta}^\top} &= \frac{1}{\sigma^2} \frac{\partial \mathbf{X}^\top(\boldsymbol{y}-\mathbf{X}\boldsymbol{\beta})}{\partial \boldsymbol{\beta}^\top} = \frac{\mathbf{X}^\top\mathbf{X}}{\sigma^2}\\ -\frac{\partial^2 \ell(\boldsymbol{\beta}, \sigma^2)}{\partial \boldsymbol{\beta}\partial \sigma^2} &=- \frac{\mathbf{X}^\top(\boldsymbol{y}-\mathbf{X}\boldsymbol{\beta})}{\sigma^4}\\ -\frac{\partial^2 \ell(\boldsymbol{\beta}, \sigma^2)}{\partial (\sigma^2)^2} &= -\frac{n}{2\sigma^4} + \frac{(\boldsymbol{y}-\mathbf{X}\boldsymbol{\beta})^\top(\boldsymbol{y}-\mathbf{X}\boldsymbol{\beta})}{\sigma^6}. \end{align*}\] Si on évalue l’information observée aux EMV, on obtient \[\begin{align*} j(\widehat{\boldsymbol{\beta}}, \widehat{\sigma^2}) = \begin{pmatrix} \frac{\mathbf{X}^\top\mathbf{X}}{\widehat{\sigma^2}} & \boldsymbol{0}_{p+1} \\ \boldsymbol{0}_{p+1}^\top & \frac{n}{2\widehat{\sigma^4}} \end{pmatrix} \end{align*}\] puisque \(\widehat{\sigma}^2=\mathsf{SC}_e/n\) et que les résidus sont orthogonaux à la matrice du modèle. Sachant que \(\mathsf{E}(Y \mid \mathbf{X})=\mathbf{X}\boldsymbol{\beta},\) la matrice d’information de Fisher est \[\begin{align*} i(\boldsymbol{\beta}, \sigma^2) = \begin{pmatrix} \frac{\mathbf{X}^\top\mathbf{X}}{\sigma^2} & \boldsymbol{0}_{p+1} \\ \boldsymbol{0}_{p+1}^\top & \frac{n}{2\sigma^4} \end{pmatrix} \end{align*}\] Puisque la loi asymptotique de l’estimateur est normale, les EMV de \(\sigma^2\) et \(\boldsymbol{\beta}\) sont asymptotiquement indépendants car leur corrélation asymptotique est nulle.Pourvu que la matrice carrée \((p+1),\) \(\mathbf{X}^\top\mathbf{X}\) soit inversible, la variance asymptotique des estimateurs est \(\mathsf{Var}(\widehat{\boldsymbol{\beta}})=\sigma^2(\mathbf{X}^\top\mathbf{X})^{-1}\) et \(\mathsf{Var}(\widehat{\sigma}^2) = 2\sigma^4/n.\)

Remarque 4.3. Si on suppose que les observations sont normales, alors on peut montrer que \(\mathsf{SC}_e/\sigma^2 \sim \chi^2_{n-p-1}\) et \(\widehat{\boldsymbol{\beta}} \sim \mathsf{normale}\{\boldsymbol{\beta}, \sigma^2(\mathbf{X}^\top\mathbf{X})^{-1}\}\) sont indépendants et leurs lois sont connues. Cela nous permettra de construire des tests d’hypothèse.

4.3.3 Ajustement des modèles linéaires à l’aide d’un logiciel

Bien que nous puissions construire la matrice du modèle nous-mêmes et utiliser la formule des moindres carrés de l’Équation 4.1, les routines numériques implémentées dans les logiciels sont préférables car plus stables. La fonction lm dans R ajuste les modèles linéaires, tout comme glm avec les arguments par défaut. Les objets de la classe lm ont plusieurs méthodes qui vous permettent d’extraire des objets spécifiques des objets lm. Par exemple, les fonctions coef, resid, fitted, model.matrix renvoient les estimations des coefficients \(\widehat{\boldsymbol{\beta}},\) les résidus ordinaires \(\boldsymbol{e},\) les valeurs ajustées \(\widehat{\boldsymbol{y}}\) et la matrice du modèle \(\mathbf{X}.\)

data(BSJ92, package = "hecedsm") # charger les données

str(BSJ92) # vérifier que les variables catégorielles sont "factor"

# Ajustement de la régression linéaire

linmod <- lm(posttest1 ~ pretest1 + group,

data = BSJ92)

est_beta <- coef(linmod) # coefficients (betas)

vcov_beta <- vcov(linmod) # matrice de covariance des betas

summary(linmod) # tableau résumé

beta_ic <- confint(linmod) # IC de Wald pour betas

y_adj <- fitted(linmod) # valeurs ajustées

e <- resid(linmod) # résidus ordinaires

# Vérifier la formule des moindres carrés ordinaires

X <- model.matrix(linmod) # matrice du modèle

y <- college$salary

isTRUE(all.equal(

c(solve(t(X) %*% X) %*% t(X) %*% y),

as.numeric(coef(linmod))

))La méthode summary est sans doute la plus utile: elle affiche les estimations des paramètres de la moyenne ainsi que leurs erreurs type, les valeurs \(t\) pour le test de Wald de l’hypothèse \(\mathscr{H}_0 : \beta_i=0\) et les valeurs-\(p\) associées. D’autres statistiques descriptives, portant sur la taille de l’échantillon, les degrés de liberté, etc. sont données au bas du tableau. Notez que la fonction lm utilise l’estimateur sans biais de la variance \(\sigma^2.\)

4.4 Prédictions

Une fois les estimations des coefficients obtenues, on peut calculer les valeurs ajustées \(\widehat{\boldsymbol{y}}\) avec \(\mathbf{X}\widehat{\boldsymbol{\beta}},\) où \(\mathbf{X}\) dénote la matrice du modèle \(n \times (p+1).\) On peut aussi généraliser cette approche et obtenir une estimation de la moyenne pour n’importe quel vecteur lignes de covariables \(\mathbf{x}^* = (1, x^*_1, \ldots, x^*_p),\) sachant que \(\mathsf{E}(Y \mid \mathbf{x}^*)=\mathbf{x}^*\boldsymbol{\beta},\) en remplaçant les coefficients inconnus \(\boldsymbol{\beta}\) par leurs estimations \(\widehat{\boldsymbol{\beta}}.\) Pour le modèle postulé, c’est le meilleur prédicteur linéaire non-biaisé de la moyenne.

Si l’on veut prédire la valeur d’une nouvelle observation, disons \(Y^*,\) dont le vecteur de variables explicatives \(\mathbf{x}^*\) sont connues, la prédiction sera donc \(\widehat{y}^* = \mathbf{x}^*\widehat{\boldsymbol{\beta}}\) parce que \[\begin{align*} \mathsf{E}(\widehat{Y}^* \mid \mathbf{X}, \mathbf{x}^*) = \mathsf{E}(\mathbf{x}^*\widehat{\boldsymbol{\beta}}\mid \mathbf{X}, \mathbf{x}^*) = \mathbf{x}^*\boldsymbol{\beta}. \end{align*}\] Cependant, les observations individuelles varient davantage que les moyennes (qui sont elles-mêmes basées sur plusieurs observations). Intuitivement, cela est dû à l’incertitude supplémentaire du terme d’erreur apparaissant dans l’équation du modèle: la variabilité des prédictions est la somme de l’incertitude due aux estimateurs (basés sur des données aléatoires) et de la variance intrinsèque des observations en supposant que la nouvelle observation est indépendante de celles utilisées pour estimer les coefficients, \[\begin{align*} \mathsf{Va}(Y^*-\widehat{Y}^* \mid \mathbf{X}, \mathbf{x}^*) &= \mathsf{Va}(Y^* - \mathbf{x}^*\widehat{\boldsymbol{\beta}} \mid \mathbf{X}, \mathbf{x}^*) \\&=\mathsf{Va}(Y^* \mid \mathbf{X}, \mathbf{x}^*) + \mathsf{Va}(\mathbf{x}^*\widehat{\boldsymbol{\beta}} \mid \mathbf{X}, \mathbf{x}^*) \\& = \sigma^2 + \sigma^2\mathbf{x}^{*\vphantom{\top}}(\mathbf{X}^\top\mathbf{X})^{-1}\mathbf{x}^{*\top}. \end{align*}\] On peut baser les intervalles de prédictions sur la loi Student-\(t,\) à l’aide du pivot \[\begin{align*} \frac{Y^*-\mathrm{x}^*\widehat{\boldsymbol{\beta}}}{\sqrt{S^2\{1+\mathrm{x}^*(\mathbf{X}^\top\mathbf{X})^{-1}\mathrm{x}^{*\top}\}}}\sim \mathsf{Student}(n-p-1). \end{align*}\] On obtient l’intervalle de prédiction de niveau \(1-\alpha\) pour \(Y^*\) en inversant la statistique de test \[\begin{align*} \mathrm{x}^*\widehat{\boldsymbol{\beta}}\pm \mathfrak{t}_{n-p-1}(\alpha/2)\sqrt{S^2\{1+\mathrm{x}^*(\mathbf{X}^\top\mathbf{X})^{-1}\mathrm{x}^{*\top}\}}. \end{align*}\] Des calculs similaires pour les intervalles de confiance ponctuels pour la moyenne \(\mathrm{x}^*\boldsymbol{\beta}\) donnent \[\begin{align*} \mathrm{x}^*\widehat{\boldsymbol{\beta}}\pm \mathfrak{t}_{n-p-1}(\alpha/2)\sqrt{S^2\mathrm{x}^*(\mathbf{X}^\top\mathbf{X})^{-1}\mathrm{x}^{*\top}}. \end{align*}\] Les deux formules diffèrent uniquement au niveau de la variabilité.

Exemple 4.12 (Prédiction pour une régression linéaire simple) Considérons les données de l’Exemple 4.5. On ajuste un modèle de régression linéaire simple avec \(\texttt{pef} = \beta_0 + \beta_1 \texttt{proportion} + \varepsilon,\) où \(\varepsilon \sim \mathsf{normale}(0,\sigma^2)\) et on suppose les observations indépendantes.

La Figure 4.6 montre les bandes d’incertitude ponctuelles pour une simple régression linéaire des données de Sokolova, Krishna, et Döring (2023) en fonction de la proportion de carton par rapport au plastique, les valeurs les plus élevées indiquant un emballage avec plus de carton superflu. Le modèle ne tient pas compte du fait que notre réponse provient d’une distribution discrète limitée avec des valeurs entières allant de 1 à 7, et que les ratios testés dans l’expérience sont 0 (pas de carton), 0.5, 1 et 2 uniquement. La droite centrale donne la prédiction des individus lorsque nous faisons varier la proportion carton/plastique. En examinant les formules des intervalles de confiance et de prédiction, il est clair que les bandes ne sont pas linéaires (nous considérons la racine carrée d’une fonction qui implique les prédicteurs), mais il n’est pas évident visuellement que l’incertitude augmente au fur et à mesure que l’on s’éloigne de la moyenne des prédicteurs.

Il est plus facile de s’en rendre compte en reproduisant les courbes potentielles qui auraient pu se produire avec des données différentes: la Figure 4.6 montre les nouvelles pentes potentielles générées à partir de la distribution normale asymptotique des estimateurs \(\widehat{\boldsymbol{\beta}}.\) La forme hyperbolique n’est pas surprenante: nous pivotons essentiellement les courbes à partir de la pef/proportion moyenne, et leur potentiel de déviation est d’autant plus élevé que nous nous éloignons de la moyenne dans chaque direction. Les intervalles de prédiction (gris pâle) sont très larges et couvrent essentiellement l’ensemble des valeurs potentielles de l’échelle de Likert sur la perception du respect de l’environnement, à l’exception de quelques observations. En revanche, les intervalles de confiance pour la moyenne sont assez étroits, en raison de la taille importante de l’échantillon. On constate également que les courbes s’en écartent peu.

pef) en fonction de la proportion de carton par rapport au plastique, avec des observations décalées horizontalement. Le graphique montre les prédictions ainsi que les intervalles de confiance ponctuels à 95 % de la moyenne et des prédictions individuelles. L’axe des ordonnées a été tronqué.

Dans R, la fonction générique predict prend comme arguments un modèle et une nouvelle base de données newdata contenant un tableau avec la même structure que les données qui ont servi à l’ajustement du modèle (à minima, les colonnes de variables explicatives utilisées dans le modèle).

data(SKD23_S2A, package = "hecedsm") # charger les données

lm_simple <- lm(pef ~ proportion, data = SKD23_S2A) # régression linéaire simple

predict(lm_simple,

newdata = data.frame(proportion = c(0, 0.5, 1, 2)),

interval = "prediction") # intervalles de prédiction

predict(lm_simple,

newdata = data.frame(proportion = c(0, 0.5, 1, 2)),

interval = "confidence") # IC de confiance pour la moyenneproportion |

prédiction | borne inf. | borne sup. |

|---|---|---|---|

| 0.0 | 2.41 | -0.168 | 4.98 |

| 0.5 | 2.67 | 0.097 | 5.24 |

| 1.0 | 2.93 | 0.361 | 5.51 |

| 2.0 | 3.46 | 0.884 | 6.04 |

| moyenne | borne inf. | borne sup. |

|---|---|---|

| 2.41 | 2.27 | 2.55 |

| 2.67 | 2.57 | 2.77 |

| 2.93 | 2.84 | 3.02 |

| 3.46 | 3.30 | 3.62 |

4.5 Tests d’hypothèses

Les tests d’hypothèses dans les modèles linéaires et d’analyse de la variance suivent la procédure usuelle: nous comparons deux modèles emboîtés, dont l’un (le modèle nul) est une simplification d’un modèle plus complexe (modèle alternatif) obtenu en imposant des restrictions sur les coefficients de la moyenne.

Les tests de restrictions pour les composantes de \(\boldsymbol{\beta}\) sont particulièrement intéressants. Les propriétés de l’estimateur du maximum de vraisemblance pour les grands échantillons impliquent que \[\begin{align*} \widehat{\boldsymbol{\beta}} \stackrel{\cdot}{\sim}\mathsf{normale}_{p+1}\left\{\boldsymbol{\beta}, \sigma^2(\mathbf{X}^\top\mathbf{X})^{-1}\right\} \end{align*}\] pour une taille d’échantillon suffisamment grande, et ce résultat est exact si les observations sont normales. On peut aisément obtenir les erreurs-type des coefficients en remplaçant \(\sigma^2\) par un estimé; avec des données normales, on peut montrer que la somme du carré des erreurs \(\mathsf{SC}_e \sim \sigma^2\chi^2_{n-p-1}\) et \(\mathsf{SC}_e\) est indépendante de \(\widehat{\boldsymbol{\beta}}.\)

Dans un contexte inférentiel, il est souvent important de tester si l’effet d’une variable explicative est significatif : si \(x_j\) est binaire ou continu, le test pour \(\mathscr{H}_0 : \beta_j=0\) correspond à un effet marginal nul pour \(x_j.\) Le modèle nul est une régression linéaire dans laquelle nous supprimons la \((j+1)\)ème colonne de \(\mathbf{X}.\)

Proposition 4.4 (Tests de Wald en régression linéaire) Rappelons que la statistique du test de Wald pour l’hypothèse \(\mathscr{H}_0: \beta_j=b\) est \[W = \frac{\widehat{\beta}_j - b}{\mathsf{se}(\widehat{\beta}_j)}.\] La statistique du test de Wald est rapportée par la plupart des logiciels pour l’hypothèse \(b=0.\) Puisque \(\mathsf{Var}(\widehat{\beta}_j) = \sigma^2 [(\mathbf{X}^\top\mathbf{X})^{-1}]_{j,j},\) nous pouvons estimer l’erreur type à partir de \(S^2\) et en déduire que la distribution de \(W\) sous l’hypothèse nulle est \(\mathsf{Student}(n-p-1).\) Cela explique la terminologie « \(t\) values » dans le tableau summary. Outre les estimations des coefficients, il est possible d’obtenir des intervalles de confiance basés sur Wald pour \(\beta_j,\) qui comme à l’accoutumée sont de la forme \(\widehat{\beta}_j \pm \mathfrak{t}_{n-p-1,\alpha/2} \mathsf{se}(\widehat{\beta}_j),\) avec \(\mathfrak{t}_{n-p-1,\alpha/2}\) le quantile de niveau \(1-\alpha/2\) d’une loi \(\mathsf{Student}({n-p-1}).\)

Exemple 4.13 Considérons les données de Exemple 4.5. Si nous ajustons le modèle de régression linéaire simple, nous pouvons extraire les valeurs -\(p\) pour les tests de Wald ou tests-\(t.\) Le test pour l’ordonnée à l’origine est sans intérêt puisque les données sont mesurées sur une échelle de 1 à 7, de sorte que la réponse moyenne lorsque proportion=0 ne peut être nulle. Le coefficient de proportion suggère une tendance de 0.5 point par unité de ratio, et il est significativement différent de zéro, ce qui indique que le score pef change avec le ratio carton/plastique.

# tests-t (Wald) pour beta=0 avec valeurs-p

summary(lm_simple)$coefficients

#> Estimate Std. Error t value Pr(>|t|)

#> (Intercept) 2.407 0.0723 33.31 2.56e-153

#> proportion 0.526 0.0618 8.51 8.40e-17

confint(lm_simple) # intervalles de confiance pour betas

#> 2.5 % 97.5 %

#> (Intercept) 2.266 2.549

#> proportion 0.405 0.648Pour les variables catégorielles à plus de deux niveaux, tester si \(\beta_j=0\) n’est généralement pas intéressant car le coefficient représente la différence entre la catégorie \(x_j\) et la ligne de base avec la paramétrisation du modèle en terme de contrastes (traitements): ces deux catégories peuvent avoir une faible différence, mais la variable catégorielle dans son ensemble peut toujours être un prédicteur utile compte tenu des autres explications. L’hypothèse d’un contraste nul est spécifique car elle implique un modèle nul dans lequel les catégories sélectionnées sont fusionnées, ce qui dépend de la référence. Nous souhaitons plutôt comparer un modèle dans lequel toutes les variables sont présentes avec un modèle dans lequel la variable explicative catégorielle est omise.

Proposition 4.5 (Tests-F pour comparaison de modèles emboîtés) Considérons le modèle linéaire complet qui contient \(p\) variables explicatives, \[\begin{align*} \mathbb{M}_1: Y=\beta_0+\beta_1 x_1 + \cdots + \beta_p x_p + \varepsilon. \end{align*}\] Supposons sans perte de généralité que nous voulions tester \(\mathscr{H}_0 : \beta_{k+1}=\beta_{k+2}=\cdots=\beta_p=0\) pour \(k < p\) (on pourrait permuter les colonnes de la matrice du modèle pour obtenir cette configuration). L’hypothèse globale spécifie que \((p-k)\) des paramètres \(\beta\) sont nuls. Le modèle restreint correspondant à l’hypothèse nulle ne contient que les covariables pour lesquelles \(\beta_j \neq 0,\) \[\begin{align*} \mathbb{M}_0: Y=\beta_0+\beta_1 x_1 + \cdots + \beta_k x_k + \varepsilon. \end{align*}\] Soit \(\mathsf{SC}_e(\mathbb{M}_1)\) la somme du carré des résidus du modèle complet \(\mathbb{M}_1,\) \[\begin{align*} \mathsf{SC}_e(\mathbb{M}_1)=\sum_{i=1}^n (Y_i-\widehat{Y}_i^{\mathbb{M}_1})^2, \end{align*}\] où \(\hat{Y}_i^{\mathbb{M}_1}\) est la \(i\)e valeur ajustée du modèle \(\mathbb{M}_1.\) On définit de la même façon la somme du carré des résidus, \(\mathsf{SC}_e(\mathbb{M}_0),\) pour le modèle \(\mathbb{M}_0.\) Logiquement, \(\mathsf{SC}_e(\mathbb{M}_0) \geq \mathsf{SC}_e(\mathbb{M}_1).\)

La statistique \(F\) est \[\begin{align*} F=\frac{\{\mathsf{SC}_e(\mathbb{M}_0)-\mathsf{SC}_e(\mathbb{M}_1)\}/(p-k)}{\mathsf{SC}_e(\mathbb{M}_1)/(n-p-1)}. \end{align*}\] Sous \(\mathscr{H}_0,\) la statistique \(F\) suit une loi de Fisher (Définition 1.12) avec \((p-k)\) et \((n-p-1)\) degrés de liberté, \(\mathsf{Fisher}(p-k, n-p-1).\) Les degrés de libertés du numérateur, \(p-k,\) indiquent le nombre de restrictions ou la différence du nombre de paramètres, tandis que celle du dénominateur, \(n-p-1\) est la taille de l’échantillons moins le nombre de paramères pour la moyenne du modèle \(\mathbb{M}_1.\)

Quand la \(j\)e variable explicative est continue ou binaire, le test \(F\) est équivalent au test \(t\) pour \(\beta_j=0.\) En effet, la statistique \(F\) est le carré de la statistique de Wald, et ils mènent à la même inférence — les valeurs-\(p\) sont identiques. Bien qu’il soit rapporté dans les tableaux, le test pour \(\beta_0=0\) n’est pas intéressant; nous conservons l’ordonnée à l’origine uniquement pour centrer les résidus.

Remarque 4.4 (Tests F versus test du rapport de vraisemblance). Pour la régression linéaire normale, le test du rapport de vraisemblance pour comparer les modèles \(\mathbb{M}_1\) et \(\mathbb{M}_0\) est une fonction de la somme des carrés des résidus: la formule habituelle se simplifie à \[\begin{align*} R &= 2( \ell_{\mathbb{M}_1} - \ell_{\mathbb{M}_0}) \\&= n\ln\{\mathsf{SC}_e(\mathbb{M}_0)/\mathsf{SC}_e(\mathbb{M}_1)\}\\ &= n \ln \left( 1+ \frac{p-k}{n-p-1}F\right) \end{align*}\] Le test du rapport de vraisemblance et les tests \(F\) sont liés par une transformation monotone, et nous pouvons utiliser la distribution \(\mathsf{Fisher}\) à des fins de comparaison, plutôt que l’approximation \(\chi^2\) pour grand échantillon. Les tests \(t\) et \(F\) présentés ci-dessus pourraient donc tous deux être considérés comme des cas particuliers de tests de rapport de vraisemblance, mais en utilisant Student-\(t\) contre la distribution normale lorsque \(p-k=1,\) et \(\mathsf{Fisher}\) contre \(\chi^2\) lorsque \(p-k \ge 1.\) Lorsque \(n\) est grand, les résultats sont à peu près les mêmes.

4.5.1 Contrastes

Supposons que nous effectuions une analyse de la variance et que le test \(F\) pour l’hypothèse nulle (globale) selon laquelle les moyennes de tous les groupes sont égales soit très élevé: nous rejetons l’hypothèse nulle en faveur de l’alternative, qui stipule qu’au moins une des moyennes du groupe est différente. La question suivante sera de savoir où se situent ces différences. En effet, dans un contexte expérimental, cela implique qu’une ou plusieurs manipulations ont un effet différent des autres sur la réponse moyenne. Souvent, cela n’est pas intéressant en soi: nous pourrions être intéressés par la comparaison de différentes options par rapport à un groupe de contrôle ou déterminer si des combinaisons spécifiques fonctionnent mieux que séparément, ou trouver le meilleur traitement en comparant toutes les paires.

La question scientifique qui a justifié l’expérience peut conduire à un ensemble spécifique d’hypothèses, qui peuvent être formulées par les chercheurs comme des comparaisons entre les moyennes de différents sous-groupes. Nous pouvons normalement les exprimer sous la forme de contrastes. Si le test global \(F\) pour l’égalité des moyennes est équivalent à une pièce faiblement éclairée, les contrastes sont comparables à des projecteurs qui permettent de mettre l’accent sur des aspects particuliers des différences entre les traitements. Formellement, un contraste est une combinaison linéaire de moyennes: en clair, cela signifie que nous attribuons un poids à chaque moyenne de groupe et que nous les additionnons, puis que nous comparons ce résumé à une valeur postulée \(a,\) généralement zéro.

Les contrastes encodent la question de recherche : si \(c_i\) représente le poids de la moyenne du groupe \(\mu_i\) \((i=1, \ldots, K),\) alors nous pouvons écrire le contraste comme \(C = c_1 \mu_1 + \cdots + c_K \mu_K\) avec l’hypothèse nulle \(\mathscr{H}_0 : C=a\) pour une alternative bilatérale. L’estimation du contraste linéaire est obtenue en remplaçant la moyenne inconnue de la population \(\mu_i\) par la moyenne de l’échantillon de ce groupe, \(\widehat{\mu}_i = \overline{y}_{i}.\) Nous pouvons facilement obtenir l’erreur type de la combinaison linéaire \(C.\) La formule, l’erreur type, en supposant une taille de sous-échantillon de \(n_1, \ldots, n_K\) et une variance commune \(\sigma^2,\) est la racine carrée de \[\begin{align*} \mathsf{Va}(\widehat{C}) = \widehat{\sigma}^2\left(\frac{c_1^2}{n_1} + \cdots + \frac{c_K^2}{n_K}\right). \end{align*}\] Nous pouvons alors construire une statistique \(t\) comme d’habitude en examinant la différence entre notre valeur postulée et la moyenne pondérée observée, convenablement normalisée. Si le test global \(F\) conduit au rejet de la valeur nulle, il existe au moins un contraste significatif au même niveau. Lorsque les vecteurs de contraste sont orthogonaux, les tests ne sont pas corrélés. Mathématiquement, si nous laissons \(c_{i}\) et \(c^{*}_{i}\) désigner les poids attachés à la moyenne du groupe \(i\) comprenant \(n_i\) observations, les contrastes sont orthogonaux si \(c_{1}c^{*}_{1}/n_1 + \cdots + c_{K}c^{*}_K/n_K = 0\) ; si l’échantillon est équilibré avec le même nombre d’observations dans chaque groupe, \(n/K = n_1 =\cdots = n_K,\) nous pouvons considérer le produit scalaire des deux vecteurs de contrastes et négliger la taille des sous-échantillons.

Si nous avons \(K\) groupes, il y a \(K-1\) contrastes pour les différences deux à deux, le dernier étant capturé par la moyenne de l’échantillon pour l’effet global. Si nous nous intéressons uniquement à la différence entre groupes (par opposition à l’effet global de tous les traitements), nous imposons une contrainte de somme à zéro sur les poids, de sorte que \(c_1 + \cdots + c_K=0.\)

4.5.2 Exemples de tests

Exemple 4.14 (Test du montant des dons) Considérons l’Exemple 4.8, dans lequel nous testons les différences entre les montants libres (open-ended) et les montants suggérés (quantity). Le test qui nous intéresse est \(\mathscr{H}_0 : \beta_1=0,\) où \(\beta_1=\mu_{\texttt{oe}} - \mu_{\texttt{qty}}\) est la différence moyenne entre les groupes. Outre le fait que la différence est statistiquement significative au niveau de 5 %, nous voulons également rapporter les moyennes marginales, qui, lorsque nous avons une seule variable explicative catégorielle dans le modèle linéaire, est la moyenne empirique de chaque sous-groupe.

data("MV23_S1", package = "hecedsm")

MV23_S1 <- MV23_S1 |>

dplyr::mutate(amount2 = ifelse(is.na(amount), 0, amount))

linmod_MV23 <- lm(amount2 ~ condition, data = MV23_S1)

# Test Wald avec coefficients

summary(linmod_MV23)

#>

#> Call:

#> lm(formula = amount2 ~ condition, data = MV23_S1)

#>

#> Residuals:

#> Min 1Q Median 3Q Max

#> -8.70 -6.77 -1.77 3.23 18.23

#>

#> Coefficients:

#> Estimate Std. Error t value Pr(>|t|)

#> (Intercept) 6.771 0.377 17.95 <2e-16 ***

#> conditionquantity 1.929 0.517 3.73 0.0002 ***

#> ---

#> Signif. codes: 0 '***' 0.001 '**' 0.01 '*' 0.05 '.' 0.1 ' ' 1

#>

#> Residual standard error: 7.61 on 867 degrees of freedom

#> Multiple R-squared: 0.0158, Adjusted R-squared: 0.0147

#> F-statistic: 13.9 on 1 and 867 DF, p-value: 0.000205

# ANOVA avec tests F

anova(linmod_MV23)

#> Analysis of Variance Table

#>

#> Response: amount2

#> Df Sum Sq Mean Sq F value Pr(>F)

#> condition 1 805 805 13.9 0.0002 ***

#> Residuals 867 50214 58

#> ---

#> Signif. codes: 0 '***' 0.001 '**' 0.01 '*' 0.05 '.' 0.1 ' ' 1

# Moyennes marginales

(emm <- emmeans::emmeans(linmod_MV23, spec = "condition"))

#> condition emmean SE df lower.CL upper.CL

#> open-ended 6.77 0.377 867 6.03 7.51

#> quantity 8.70 0.354 867 8.01 9.40

#>

#> Confidence level used: 0.95

emm |> emmeans::contrast(method = "pairwise") # vecteur de contraste (1,-1)

#> contrast estimate SE df t.ratio p.value

#> (open-ended) - quantity -1.93 0.517 867 -3.730 0.0002Exemple 4.15 (Tests et contrastes pour les méthodes de compréhension de la lecture) Nous examinons maintenant les tests pour l’Exemple 4.2 et l’Exemple 4.9, avec une covariable en plus. L’objectif de Baumann, Seifert-Kessell, et Jones (1992) était de faire une comparaison particulière entre des groupes de traitement. Selon le résumé de l’article:

Les analyses quantitatives principales comportaient deux contrastes orthogonaux planifiés: l’effet de l’enseignement (TA + DRTA vs. 2 x DR) et l’intensité de l’enseignement (TA vs. DRTA).

Avec un modèle pré-post, nous allons comparer les moyennes pour une valeur commune de pretest1, ci-dessous la moyenne globale du score pretest1.

library(emmeans) # moyennes marginales

data(BSJ92, package = "hecedsm")

mod_post <- lm(posttest1 ~ group + pretest1,

data = BSJ92)

mod_post0 <- lm(posttest1 ~ pretest1,

data = BSJ92)

anova(mod_post0, mod_post) # tests F

#> Analysis of Variance Table

#>

#> Model 1: posttest1 ~ pretest1

#> Model 2: posttest1 ~ group + pretest1

#> Res.Df RSS Df Sum of Sq F Pr(>F)

#> 1 64 509

#> 2 62 365 2 143 12.2 0.000035 ***

#> ---

#> Signif. codes: 0 '***' 0.001 '**' 0.01 '*' 0.05 '.' 0.1 ' ' 1

emmeans_post <- emmeans(object = mod_post,

specs = "group")Le résultat du tableau d’analyse de la variance montre qu’il y a bien des différences entre les groupes. On peut donc s’intéresser aux moyennes marginales estimées, qui sont la moyenne de chaque groupe.

| termes | moyennes | erreur-type | ddl | borne inf. | borne sup. |

|---|---|---|---|---|---|

| DR | 6.19 | 0.52 | 62 | 5.14 | 7.23 |

| DRTA | 9.81 | 0.52 | 62 | 8.78 | 10.85 |

| TA | 8.22 | 0.52 | 62 | 7.18 | 9.27 |

Les deux hypothèses et contrastes de Baumann, Seifert-Kessell, et Jones (1992) sont \(\mathscr{H}_0: \mu_{\mathrm{TA}} + \mu_{\mathrm{DRTA}} = 2 \mu_{\mathrm{DRA}}\) ou \[\begin{align*} \mathscr{H}_0: - 2 \mu_{\mathrm{DR}} + \mu_{\mathrm{DRTA}} + \mu_{\mathrm{TA}} = 0. \end{align*}\] avec poids \(c_1=(-2, 1, 1);\) l’ordre des niveaux de traitement est (\(\mathrm{DRA},\) \(\mathrm{DRTA},\) \(\mathrm{TA}\)) et ce dernier doit correspond à celui des poids pour les contrastes. Ces derniers donnent les mêmes tests à multiple non-nul près, donc \(ac_1,\) \(a \neq 0\) donne un résultat équivalent, par exemple \((2, -1, -1)\) ou \((1, -1/2, -1/2)\) fonctionnent. Si les estimations changent, les erreurs-types sont ajustées d’autant. Un vecteur de contrastes pour \(\mathscr{H}_0: \mu_{\mathrm{TA}} = \mu_{\mathrm{DRTA}}\) est (\(0,\) \(-1,\) \(1\)): le zéro apparaît parce que la première composante, \(\mathrm{DRA}\) n’apparaît pas. Les deux contrastes sont orthogonaux puisque \((-2 \times 0) + (1 \times -1) + (1 \times 1) = 0.\)

# Identifier l'ordre de niveau du facteur

with(BSJ92, levels(group))

#> [1] "DR" "DRTA" "TA"

# DR, DRTA, TA (alphabetical)

contrastes_list <- list(

# Contrastes: combo linéaire de moyennes,

# la somme des coefficients doit être nulle

"C1: moy(DRTA+TA) vs DR" = c(-1, 0.5, 0.5),

"C2: DRTA vs TA" = c(0, 1, -1)

)

contrastes_post <-

contrast(object = emmeans_post,

method = contrastes_list)

contrastes_summary_post <- summary(contrastes_post)| contraste | estimation | erreur-type | ddl | stat | valeur-p |

|---|---|---|---|---|---|

| C1: moy(DRTA+TA) vs DR | 2.83 | 0.64 | 62 | 4.40 | 0.00 |

| C2: DRTA vs TA | 1.59 | 0.73 | 62 | 2.17 | 0.03 |

Nous pouvons examiner ces différences: puisque DRTA contre TA est une différence par paire, nous aurions pu obtenir la statistique \(t\) directement à partir des contrastes deux à deux en utilisant pairs(emmeans_post).

Quelle est la conclusion de notre analyse des contrastes? Il semble que les méthodes impliquant la réflexion à haute voix aient un impact important sur la compréhension de la lecture par rapport à la seule lecture dirigée. Les preuves ne sont pas aussi solides lorsque nous comparons la méthode qui combine la lecture dirigée, l’activité de réflexion et la réflexion à haute voix, mais la différence est néanmoins significative à niveau 5%.

# Extraire les coefficients et les erreurs-type

beta_pre <- coefficients(mod_post)['pretest1']

se_pre <- sqrt(c(vcov(mod_post)['pretest1', 'pretest1']))

wald <- (beta_pre - 1)/se_pre # test de Wald directionnel

# Valeur-p basée sur la référence nulle Student-t avec n-p-1 ddl

pval <- 2*pt(abs(wald), df = mod_post$df.residual, lower.tail = FALSE)

# Comparaison de modèles emboîtés avec appel à 'anova'

mod0 <- lm(posttest1 ~ offset(pretest1) + group, data = BSJ92)

# Le décalage (`offset`) fixe le terme, ce qui équivaut à un coefficient de 1.

aov_tab <- anova(mod0, mod_post)Une autre hypothèse potentielle intéressante consiste à tester si le coefficient de pretest1 est égal à l’unité. Cela équivaut à l’hypothèse \(b=1\) pour le test de Wald, \(w = (\widehat{\beta}_{\texttt{pretest1}}-1)/\mathsf{se}(\widehat{\beta}_{\texttt{pretest1}})= -3.024,\) ou bien une comparaison de modèles avec le test \(F\) via anova, qui donne une statistique de test de \(F=9.143.\) On peut montrer que si \(Z \sim \mathsf{Student}(\nu),\) alors \(Z^2 \sim \mathsf{Fisher}(1, \nu),\) il s’ensuit que les deux tests sont équivalents et que les valeurs-\(p\) sont exactement les mêmes.

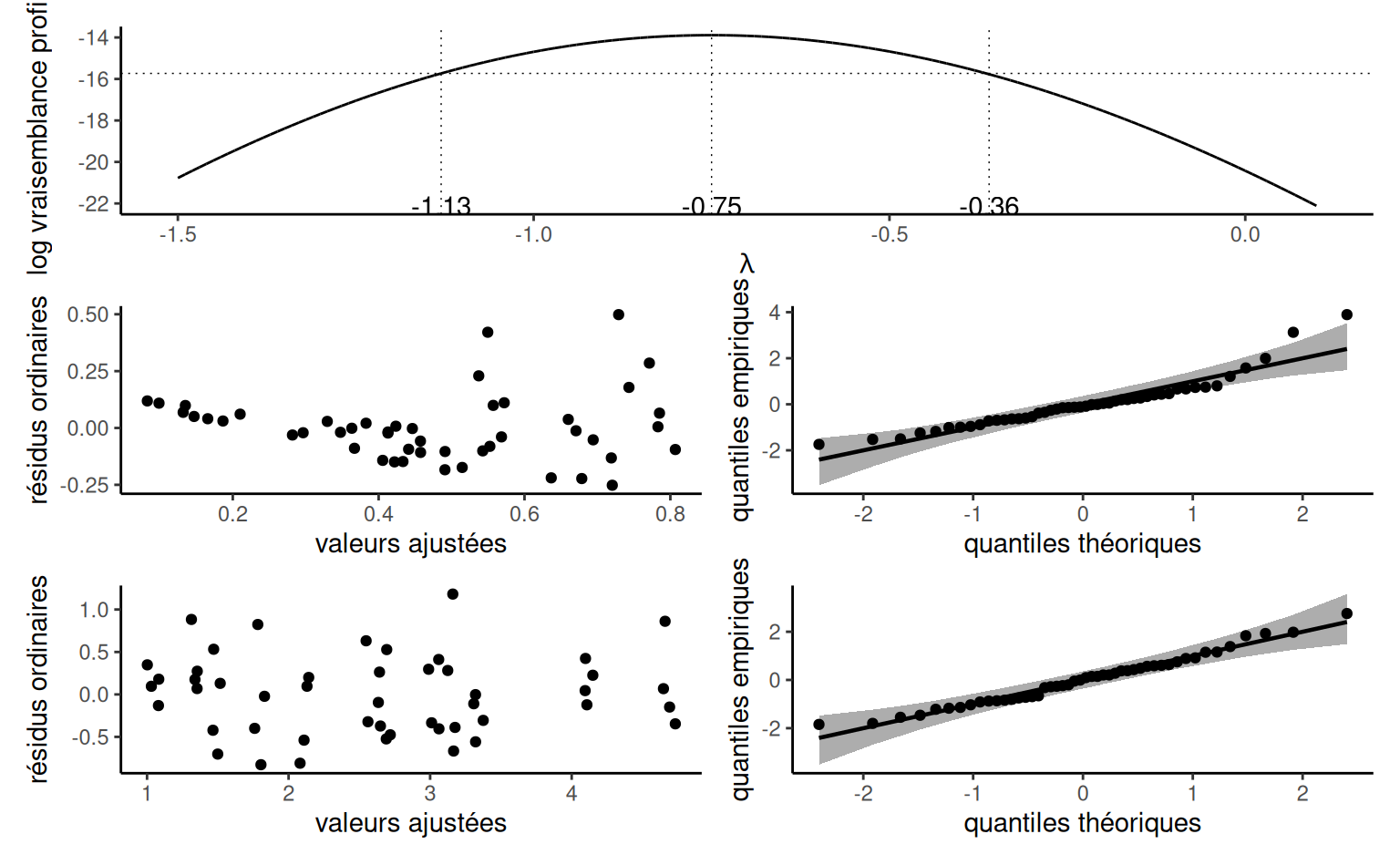

Exemple 4.16 (Tests et contrastes pour l’effet de l’emballage carton sur la perception) Soit \(\mu_{0}, \mu_{0.5}, \mu_{1}, \mu_2\) la vraie moyenne du score PEF en fonction de la proportion de carton pour les données de Exemple 4.5. Plusieurs tests pourraient être intéressants ici, mais nous nous concentrons sur les contrastes effectués par les auteurs et sur un test d’hypothèse de linéarité en fonction de la proportion de plastique. Pour ce dernier, nous pouvons comparer le modèle de régression linéaire (dans lequel le score PEF augmente linéairement avec la proportion de carton par rapport au plastique), \[\begin{align*} \mathsf{E}(\texttt{pef} \mid \texttt{proportion}) = \beta_0 + \beta_1\texttt{proportion}, \end{align*}\] au modèle d’analyse de variance qui permet à chacun des quatre groupes d’avoir des moyennes différentes. \[\begin{align*} &\mathsf{E}(\texttt{pef} \mid \texttt{proportion}) = \alpha_0 + \alpha_1 \mathbf{1}_{\texttt{proportion}=0.5} \\&\quad + \alpha_2 \mathbf{1}_{\texttt{proportion}=1} + \alpha_3\mathbf{1}_{\texttt{proportion}=2}. \end{align*}\] Si on veut obtenir l’hypothèse nulle en terme de contraintes sur les paramètres \(\boldsymbol{\alpha},\) on trouve \[\begin{align*} \mu_0 &= \beta_0=\alpha_0 \\ \mu_{0.5} &= \beta_0 + 0.5 \beta_1 = \alpha_0 + \alpha_1\\ \mu_1 &= \beta_0 + \beta_1 = \alpha_0 + \alpha_2 \\ \mu_2 &= \beta_0 + 2 \beta_1= \alpha_0 + \alpha_3. \end{align*}\] Le test comparant la régression linéaire simple à l’analyse de la variance impose deux restrictions simultanées, avec \(\mathscr{H}_0 : \alpha_3 = 2\alpha_2= 4\alpha_1,\) de sorte que la distribution nulle est \(\mathsf{Fisher}(2, 798)\) ou approximativement \(\chi^2_2.\)

data(SKD23_S2A, package = "hecedsm")

linmod <- lm(pef ~ proportion, data = SKD23_S2A)

coef(linmod) # extraire coefficients

#> (Intercept) proportion

#> 2.407 0.526

# ANOVA à un facteur

anovamod <- lm(pef ~ factor(proportion),

data = SKD23_S2A)

# Comparer les deux modèles emboîtés

anova(linmod, anovamod) # est-ce que l'effet est linéaire?

#> Analysis of Variance Table

#>

#> Model 1: pef ~ proportion

#> Model 2: pef ~ factor(proportion)

#> Res.Df RSS Df Sum of Sq F Pr(>F)

#> 1 800 1373

#> 2 798 1343 2 29.3 8.69 0.00018 ***

#> ---

#> Signif. codes: 0 '***' 0.001 '**' 0.01 '*' 0.05 '.' 0.1 ' ' 1

# Test avec code alternatif (poids pour chaque coefficient)

car::linearHypothesis(model = anovamod,

hypothesis = rbind(c(0, -2, 1, 0),

c(0, 0, -2, 1)))

#>

#> Linear hypothesis test:

#> - 2 factor(proportion)0.5 + factor(proportion)1 = 0

#> - 2 factor(proportion)1 + factor(proportion)2 = 0

#>

#> Model 1: restricted model

#> Model 2: pef ~ factor(proportion)

#>

#> Res.Df RSS Df Sum of Sq F Pr(>F)

#> 1 800 1373

#> 2 798 1343 2 29.3 8.69 0.00018 ***

#> ---

#> Signif. codes: 0 '***' 0.001 '**' 0.01 '*' 0.05 '.' 0.1 ' ' 1Le résultat montre que les tests \(F\) et les valeurs-\(p\) sont identiques, que l’on impose les contraintes manuellement ou que l’on soumette simplement les deux modèles imbriqués à la méthode anova.

Les auteurs souhaitaient comparer zéro carton avec d’autres choix: nous nous intéressons aux différences par paire, mais uniquement par rapport à la référence \(\mu_{0}\): \[\begin{align*} \mu_0 = \mu_{0.5} & \iff 1\mu_0 - 1\mu_{0.5} + 0\mu_{1} + 0 \mu_{2} = 0\\ \mu_0 = \mu_{1} & \iff 1\mu_0 + 0\mu_{0.5} -1\mu_{1} + 0 \mu_{2} = 0\\ \mu_0 = \mu_{2} & \iff 1\mu_0 + 0\mu_{0.5} + 0\mu_{1} -1 \mu_{2} = 0. \end{align*}\] Les vecteurs de poids pour les contrastes linéaires sont \((1, -1, 0, 0),\) \((1, 0, -1, 0)\) et \((1, 0, 0, -1)\) pour les moyennes marginales.

moymarg <- anovamod |>

emmeans::emmeans(specs = "proportion") # moyennes de groupes

contrastlist <- list( # liste de vecteurs de contrastes

refvsdemi = c(1, -1, 0, 0),

refvsun = c(1, 0, -1, 0),

refvsdeux = c(1, 0, 0, -1))

# calculer différences relativement à la référence

moymarg |> emmeans::contrast(method = contrastlist)

#> contrast estimate SE df t.ratio p.value

#> refvsdemi -0.749 0.131 798 -5.710 <.0001

#> refvsun -0.901 0.131 798 -6.890 <.0001

#> refvsdeux -1.182 0.129 798 -9.200 <.0001Les moyennes des groupes rapportées dans le Tableau 4.6 correspondent à celles indiquées par les auteurs dans l’article. Elles suggèrent que la perception du respect de l’environnement augmente avec la quantité de carton utilisée dans l’emballage. Nous avons pu ajuster un modèle de régression simple pour évaluer le changement moyen, en traitant la proportion comme une variable explicative continue. La pente estimée pour le changement du score PEF, qui va de 1 à 7 par incréments de 0.25, est 0.53 point par rapport au carton/plastique. Il y a cependant de fortes indications, compte tenu des données, que le changement n’est pas tout à fait linéaire, puisque l’ajustement du modèle de régression linéaire est significativement plus mauvais que le modèle linéaire correspondant.

| proportion | moyenne | erreur-type | ddl | borne inf. | borne sup. |

|---|---|---|---|---|---|

| 0.0 | 2.16 | 0.093 | 798 | 1.98 | 2.34 |

| 0.5 | 2.91 | 0.093 | 798 | 2.73 | 3.09 |

| 1.0 | 3.06 | 0.092 | 798 | 2.88 | 3.24 |

| 2.0 | 3.34 | 0.089 | 798 | 3.17 | 3.52 |

| contraste | estimation | erreur-type | ddl | stat | valeur-p |

|---|---|---|---|---|---|

| refvsdemi | -0.75 | 0.13 | 798 | -5.71 | < 0.001 |

| refvsun | -0.90 | 0.13 | 798 | -6.89 | < 0.001 |

| refvsdeux | -1.18 | 0.13 | 798 | -9.20 | < 0.001 |

Toutes les différences dans le Tableau 4.7 sont significatives et positives, conformément à l’hypothèse des chercheurs.

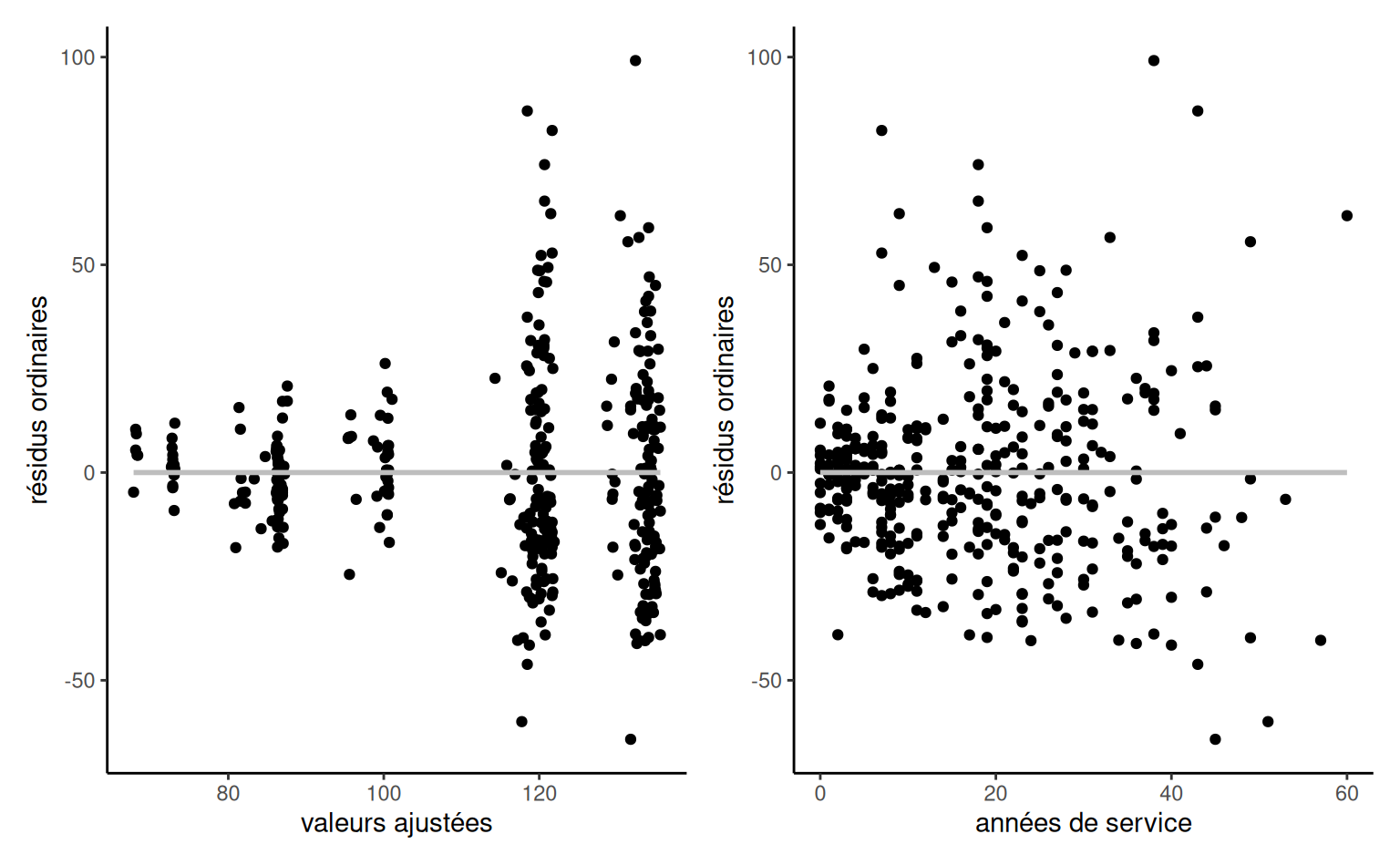

Exemple 4.17 (Tester la discrimination salariale dans l’enseignement supérieur) Considérons l’exemple des données college et le modèle linéaire associé avec echelon, sexe, années de service et domaine comme variables explicatives.

data(college, package = "hecmodstat")

mod1_college <- lm(salaire ~ sexe + domaine + echelon + service, data = college)

mod0_college <- lm(salaire ~ domaine + echelon + service, data = college)

# F-test avec "anova" comparant les modèles emboîtés

aov_tab_college <- anova(mod0_college, mod1_college)

# Test t de Wald

wald_college <- summary(mod1_college)$coefficients[2,]

# Test du rapport de vraisemblance avec approx khi-deux

pval_lrt <- pchisq(q = as.numeric(2*(logLik(mod1_college) - logLik(mod0_college))),

df = 1, lower.tail = FALSE)Le seul test qui nous intéresse ici est \(\mathscr{H}_0 : \beta_{\texttt{sexe}} = 0\) contre l’alternative bilatérale \(\mathscr{H}_a : \beta_{\texttt{sexe}} \neq 0.\) La statistique du test de Wald est \(1.23,\) avec une valeur-\(p\) de \(0.219\) basée sur une distribution Student-\(t\) avec \(391\) degrés de liberté. La valeur-\(p\) dans la sortie du test \(F\) est la même, et celle obtenue par le test du rapport de vraisemblance est la même jusqu’à la deuxième décimale.

| term | estimation | erreur-type | stat de Wald | valeur-p |

|---|---|---|---|---|

| (Intercept) | 86.596 | 2.96 | 29.25 | < 0.001 |

| sexe [femme] | -4.771 | 3.878 | -1.23 | 0.22 |

| domaine [théorique] | -13.473 | 2.315 | -5.82 | < 0.001 |

| échelon [agrégé] | 14.56 | 4.098 | 3.55 | < 0.001 |

| échelon [titulaire] | 49.16 | 3.834 | 12.82 | < 0.001 |

| service | -0.089 | 0.112 | -0.8 | 0.43 |

4.6 Plans factoriels et interactions

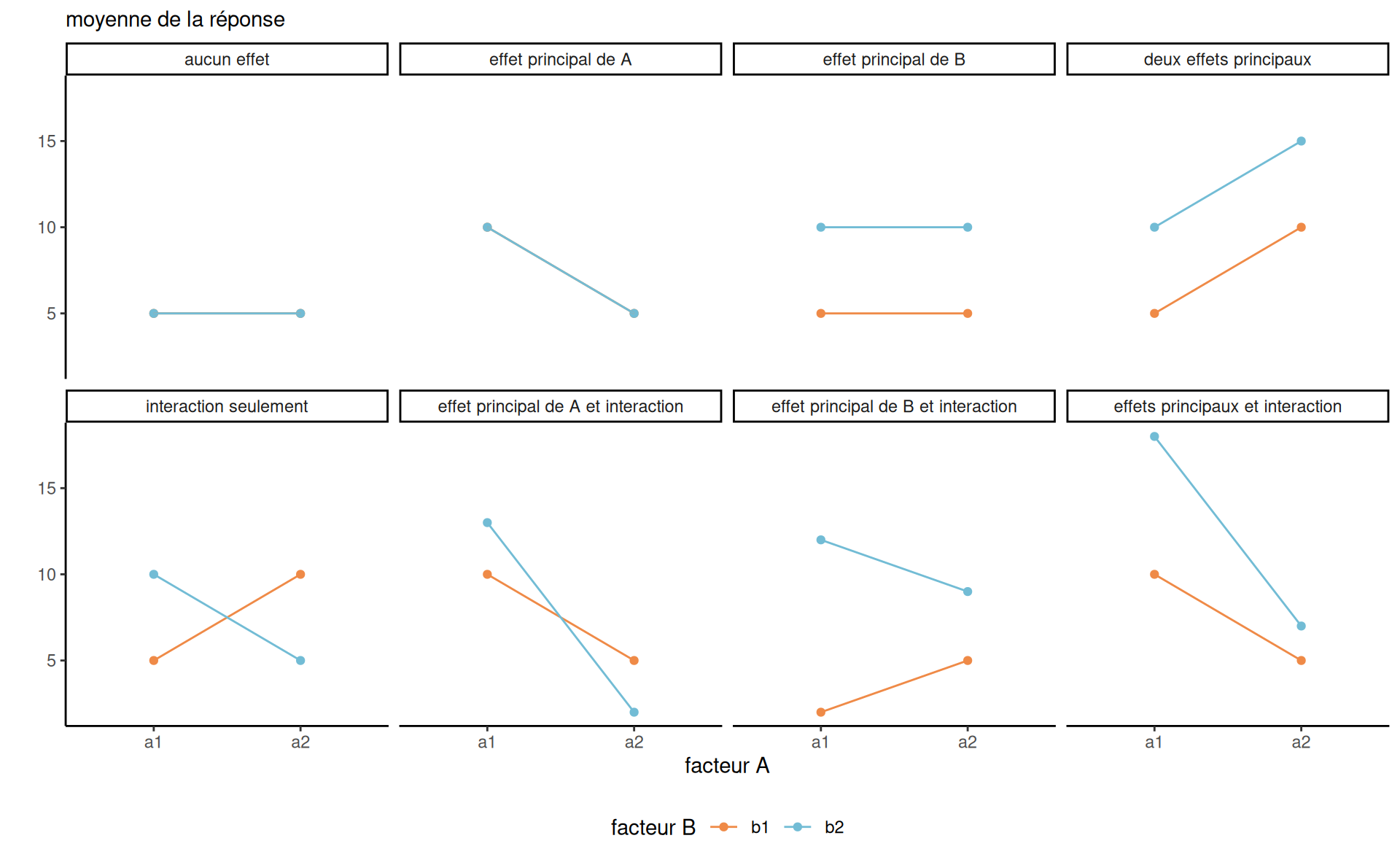

Le modèle additif pour la moyenne spécifie que l’effet marginal d’une variable ( y compris pour les variables catégorielles) est indépendant des autres. Nous pouvons souhaiter assouplir cette hypothèse en incluant des termes d’interaction.

Définition 4.2 (Interaction) On parle d’interaction lorsque des combinaisons de variables explicatives affectent la variable réponse différemment que lorsqu’elles sont considérées individuellement. Si \(X_j\) et \(X_k\) interagissent, l’effet marginal de \(\mathsf{E}(Y \mid \boldsymbol{X})\) par rapport à \(X_j\) est une fonction de \(X_k,\) et vice-versa.

On s’attarde au cas où au moins une des variables est catégorielle (facteur).

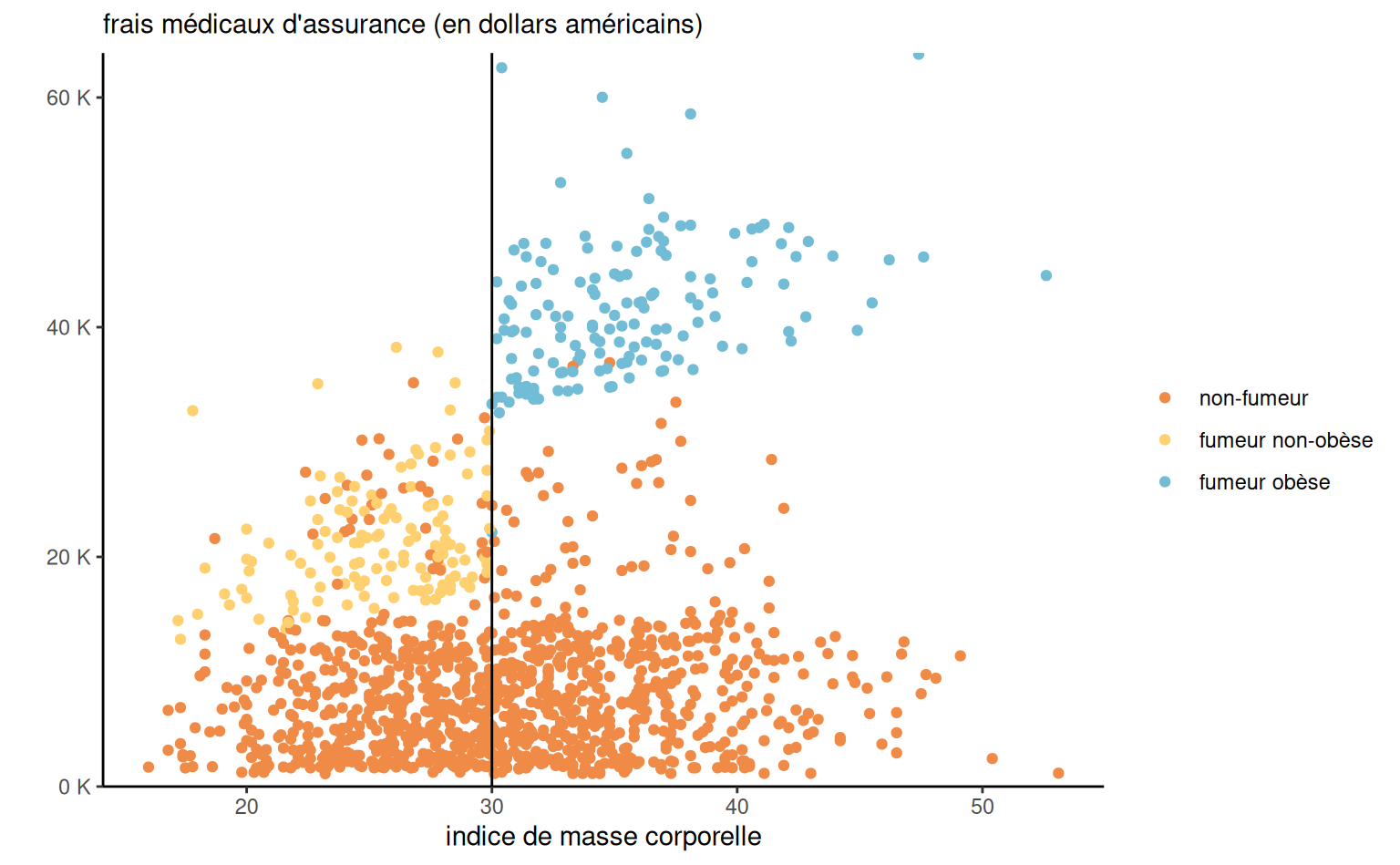

Exemple 4.18 (Primes d’assurances et interactions) On considère la relation entre fumeur et l’indice de masse corporel pour la détermination de primes d’assurance. Les fumeurs dont l’indice de masse corporelle (IMC) est égal ou supérieur à 30 paient une prime élevée, mais il semble que le montant de la prime augmente de façon linéaire en fonction de l’IMC. Cette tarification ne semble pas s’appliquer aux non-fumeurs.

assurance avec les frais en fonction de l’imc, selon le status fumeur.

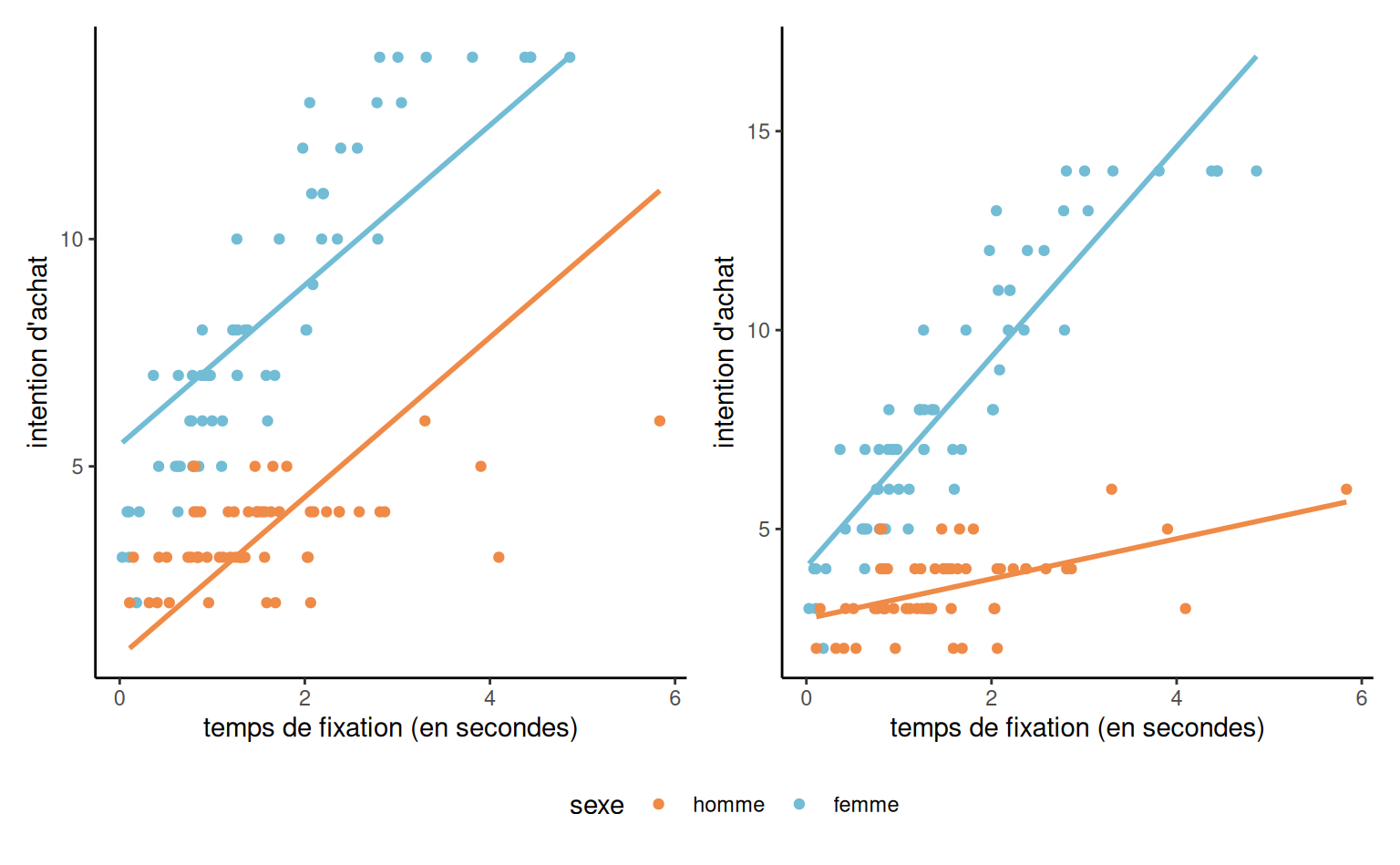

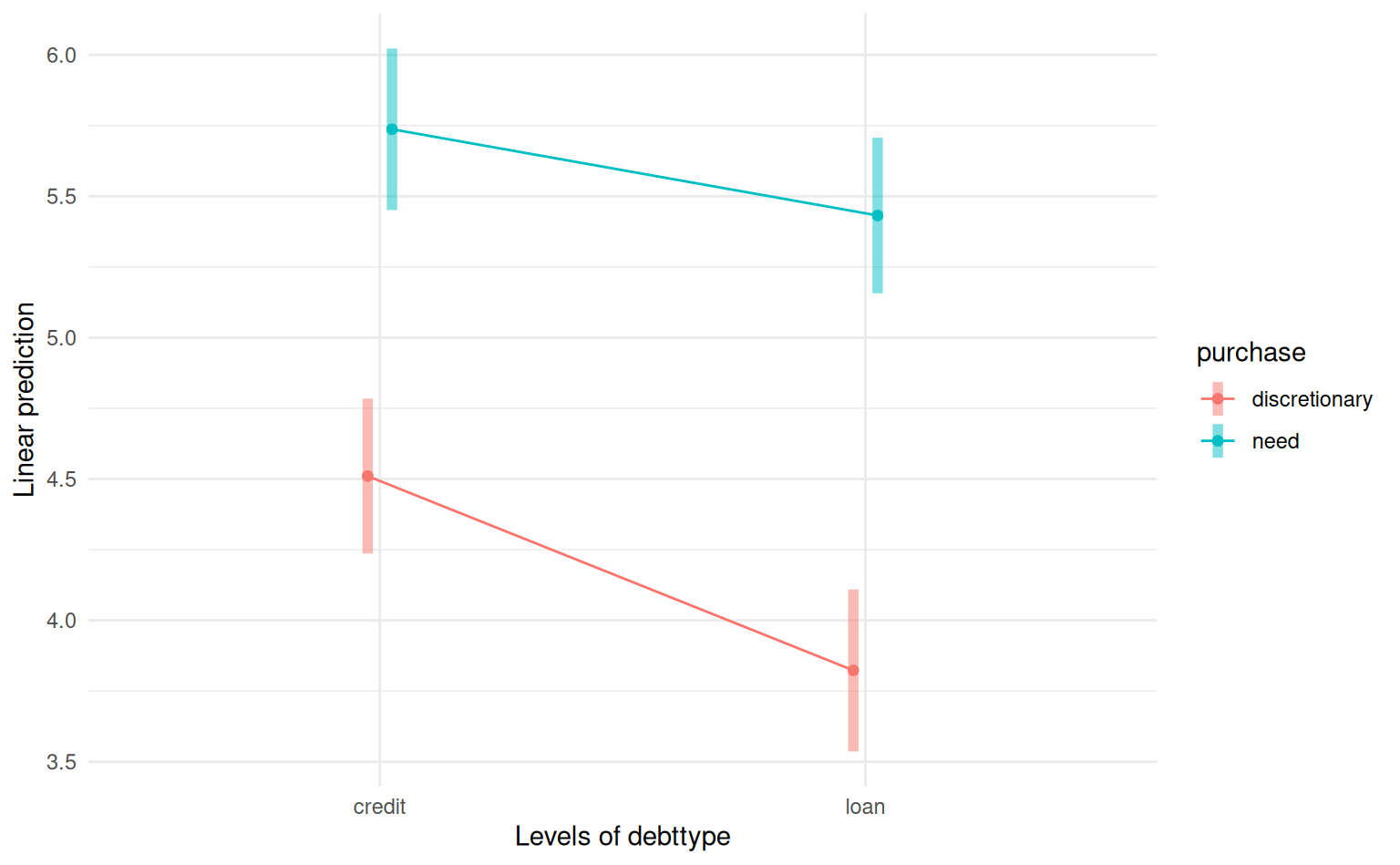

Exemple 4.19 (Intention d’achat) On considère un exemple avec des données bidons interaction. Le modèle additif (sans interaction) a pour moyenne \[\begin{align*}

\mathsf{E}(\texttt{intention} \mid \cdot)=\beta_0 + \beta_1 \texttt{sexe} + \beta_2 \texttt{fixation},

\end{align*}\] où \(\texttt{sexe=1}\) pour les femmes et \(\texttt{sexe=0}\) pour les hommes

L’effet de la variable continue fixation est identique pour les deux sexes. De même, l’effet de la variable binaire est supposé être le même pour toutes les valeurs possibles de la variable continue. Nous pouvons le voir sur le graphique, car la différence entre les lignes représente l’effet de \(\texttt{sexe},\) est le même pour toutes les valeurs de \(\texttt{fixation};\) les lignes sont parallèles : voir le panneau gauche de Figure 4.8.

Pour ajuster une pente différente par sexe, on crée une nouvelle variable égale au produit \(\texttt{fixation}\times\texttt{sexe}\) et on l’ajoute à notre modèle, \[\begin{align*} \mathsf{E}(\texttt{intention} \mid \cdot)= \beta_0 + \beta_1 \texttt{sexe} + \beta_2\texttt{fixation} + \beta_3 \texttt{fixation}\cdot \texttt{sexe}. \end{align*}\]

Selon la valeur de \(\texttt{sexe},\) on obtient \[\begin{align*} \mathsf{E}(\texttt{intention} \mid \cdot) = \begin{cases} (\beta_0 + \beta_1) + (\beta_2 + \beta_3)\texttt{fixation}, & \texttt{sexe}=1 \text{ (femme)},\\ \beta_0 + \beta_2 \texttt{fixation}, & \texttt{sexe}=0 \text{ (homme)}. \end{cases} \end{align*}\] L’interprétation des coefficients du modèle se fait comme d’habitude avec la paramétrisation (traitement):

- \(\beta_0\) est l’intention d’achat moyenne lorsque le temps de fixation est nul pour les hommes,

- \(\beta_1\) est la différence d’ordonnée à l’origine entre les femmes et les hommes (différence d’intention d’achat moyenne entre femmes et hommes quand le temps de fixation est nul),

- \(\beta_2\) est l’augmentation unitaire de l’intention d’achat par seconde de fixation pour les hommes,

- \(\beta_3\) est la différence de pente entre les femmes et les hommes (différence d’intention d’achat moyenne femmes vs hommes pour une augmentation d’une seconde de fixation).

Tester la significativité de l’interaction revient à vérifier si \(\mathscr{H}_0: \beta_3=0.\)

data(interaction, package = "hecmodstat")

# Pour spécifier une interaction, utiliser :

mod <- lm(intention ~ sexe + fixation + sexe:fixation,

data = interaction)

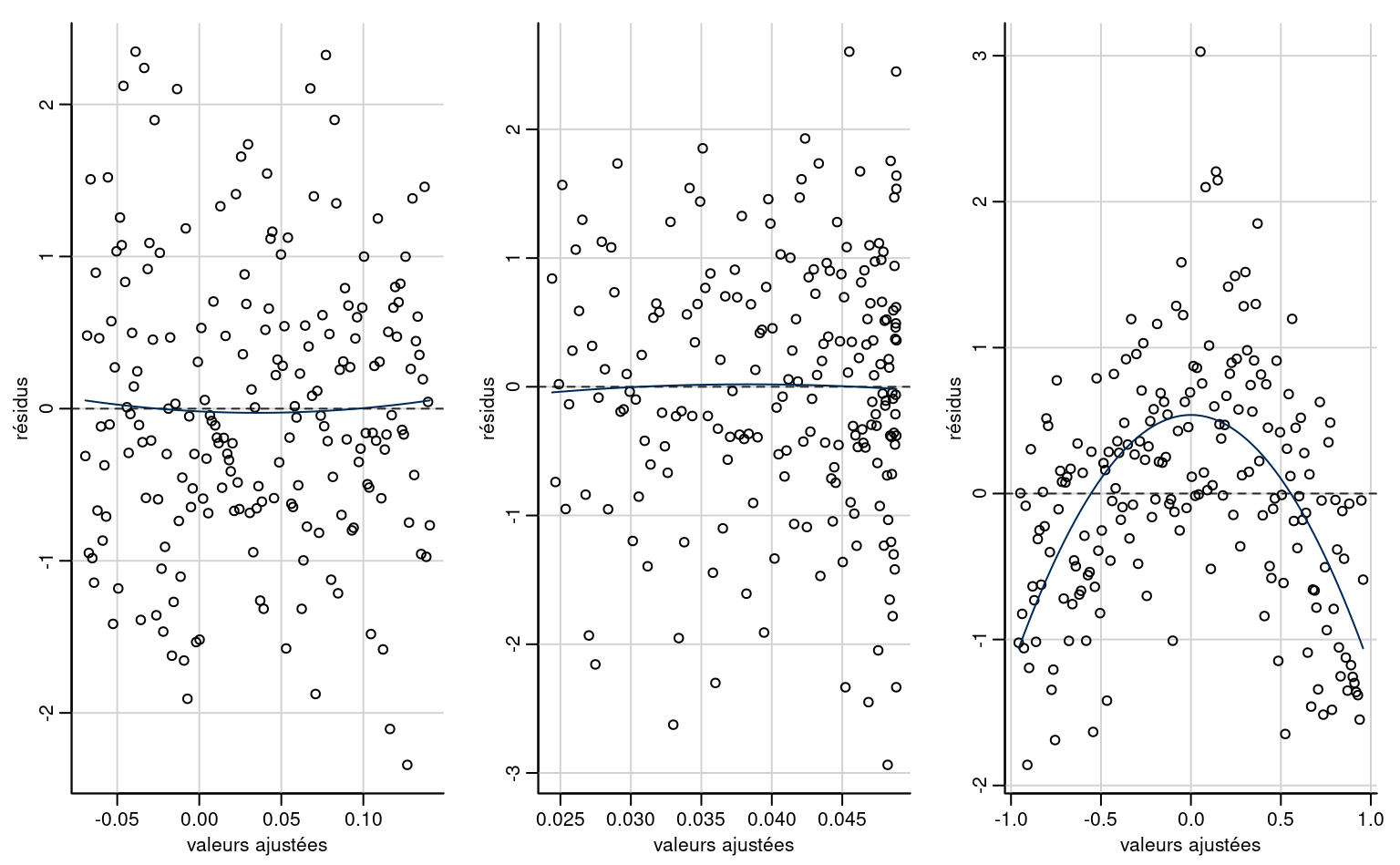

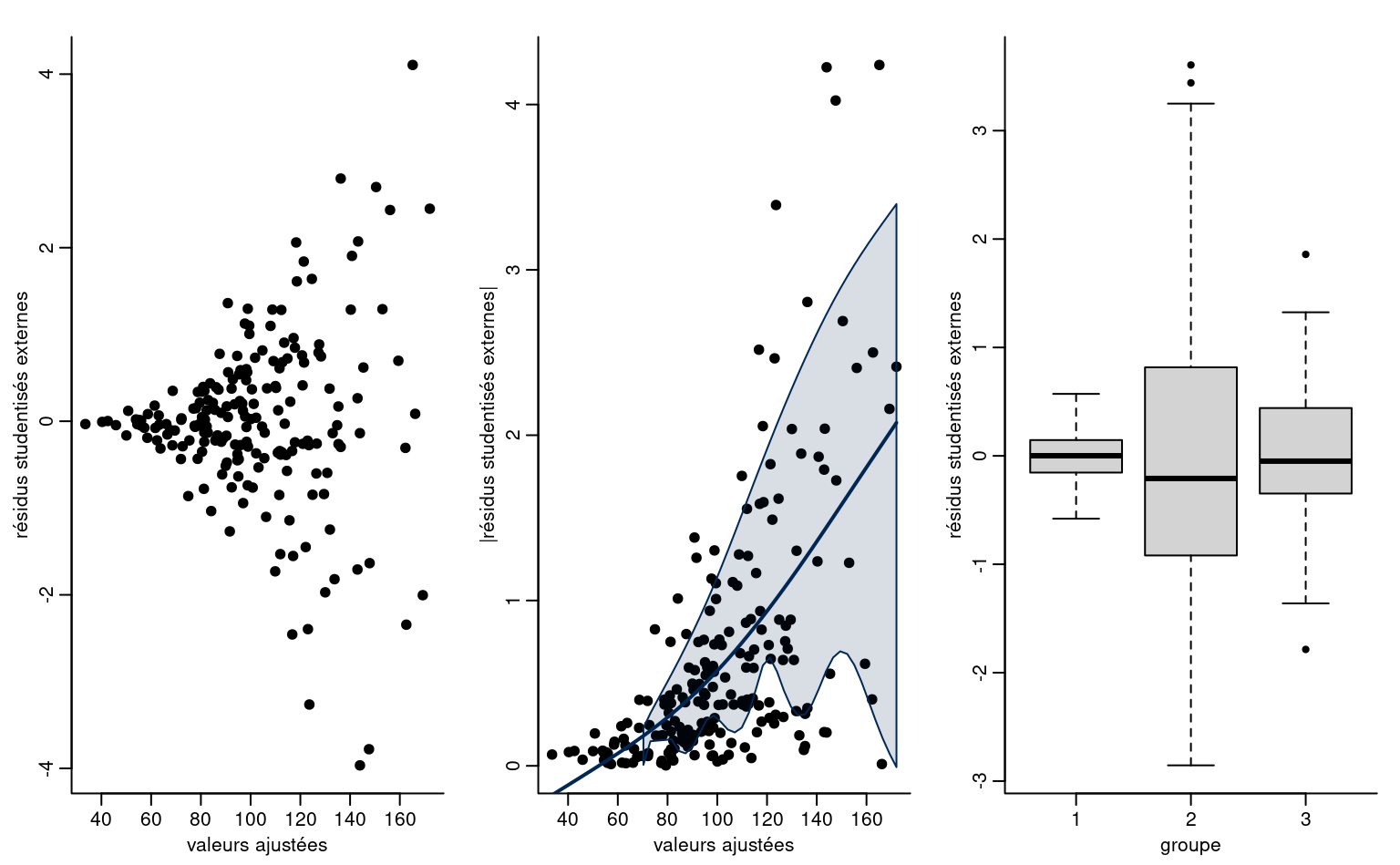

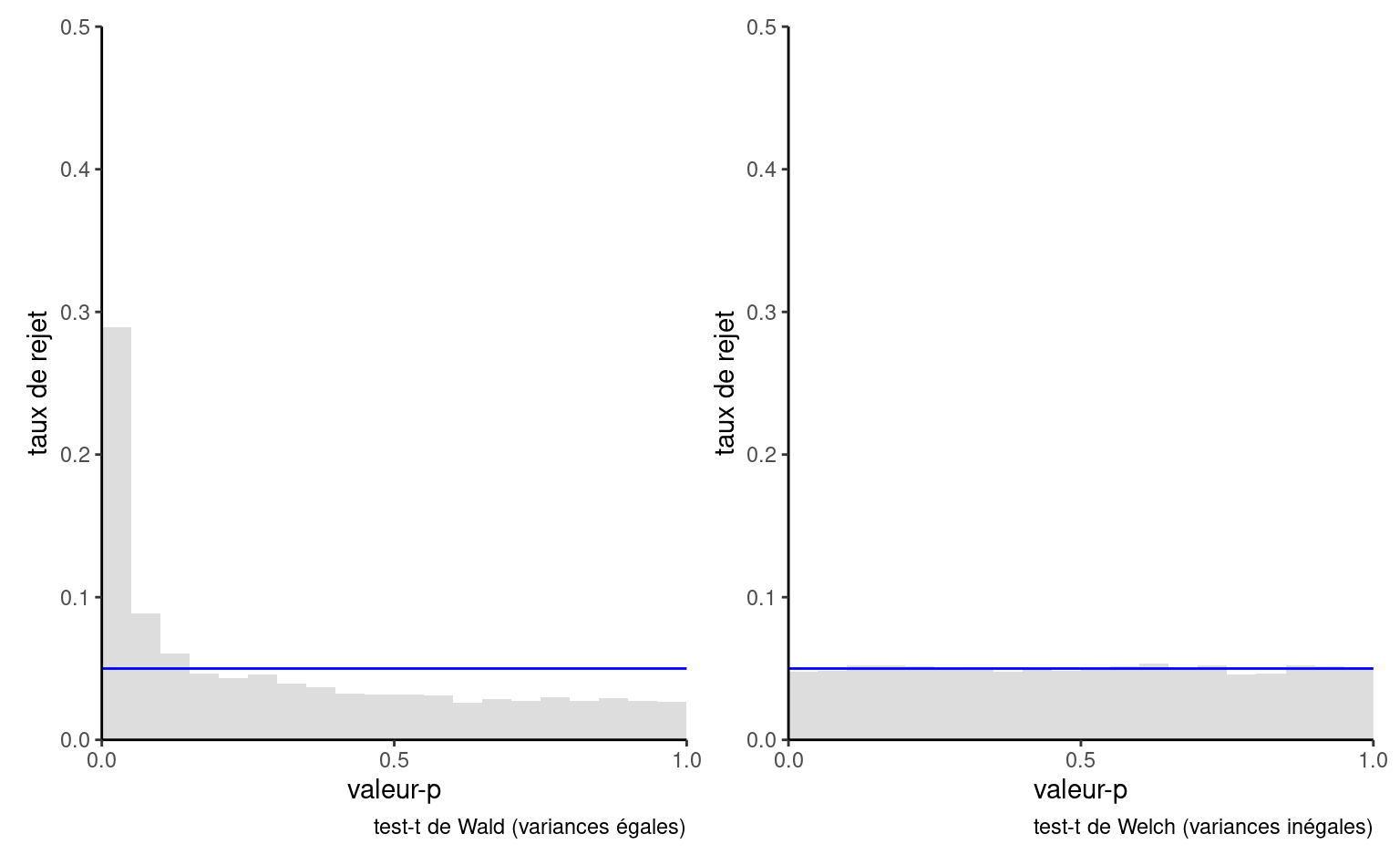

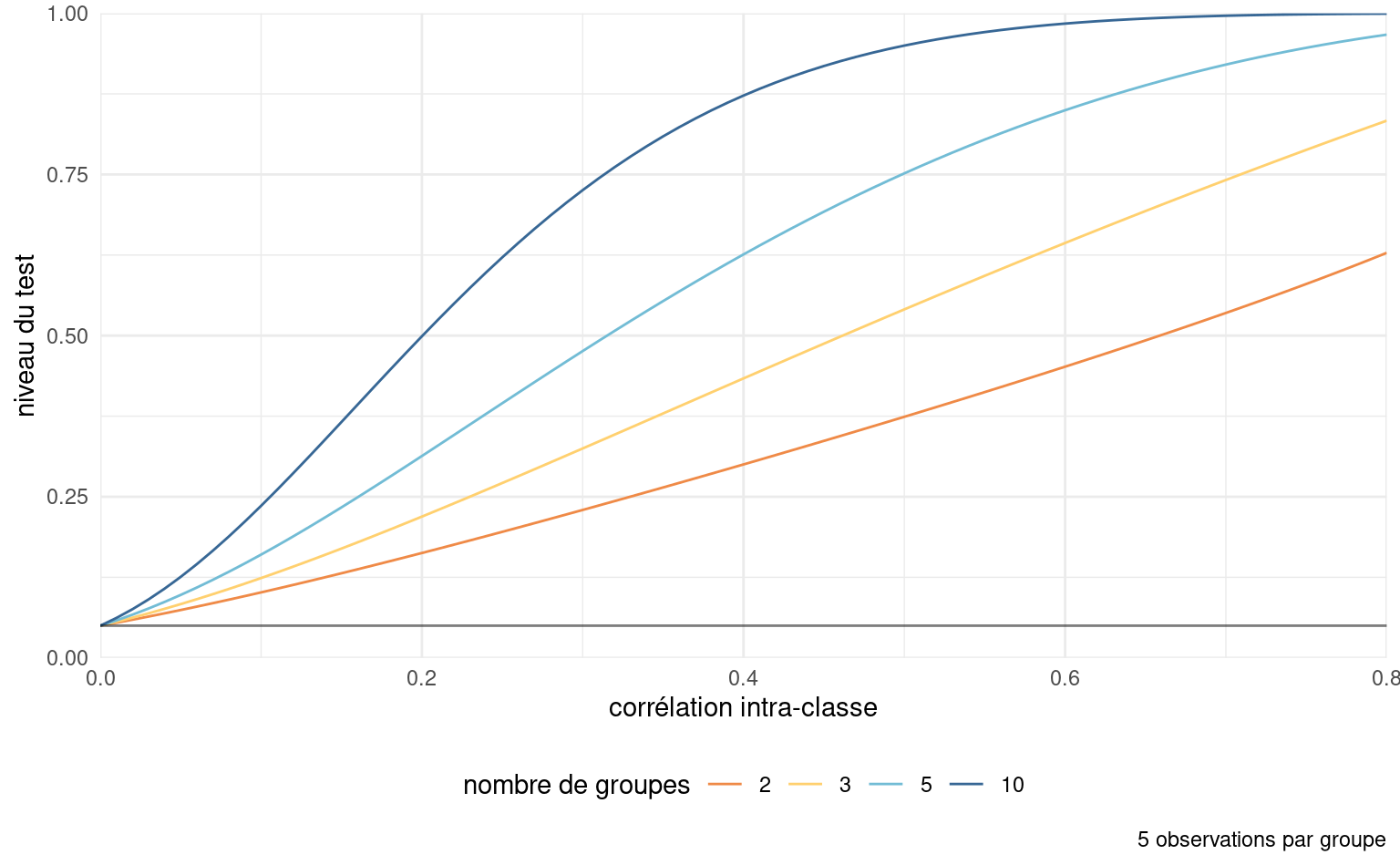

# Un raccourci est sexe*fixation, qui donne la même chose